Vmware 7 iscsi настройка

Эксплуатация технически сложного оборудования, типа систем хранения данных, подразумевает наличие у администратора определенных навыков. Однако высокие технологии шагают в массы. И, соответственно, растет число пользователей, впервые столкнувшиеся с ними. Уверены, что статьи в стиле How To являются отличным способом пополнить багаж знаний как для новичков, так и узнать нюансы и особенности для опытных пользователей.

В данной статье мы рассмотрим порядок подключения СХД Qsan к гипервизору VMware ESXi, а также по возможности дадим практические советы по тюнингу настроек для достижения максимальной эффективности использования оборудования.

В рамках данной статьи мы рассмотрим процессы подключения СХД Qsan с использованием блочных протоколов доступа iSCSI и Fibre Channel. Условно в процессе подключения можно выделить несколько основных этапов:

- Физическая и логическая коммутация

- Действия на стороне СХД

- Действия на стороне хоста(ов)

В статье приведены скриншоты настройки гипервизоров ESXi 6.7 под управлением vSphere. В случае Standalone ESXi пункты меню могут называться чуть иначе и ряд настроек отсутствовать.

Физическая и логическая коммутация

Совокупность оборудования и линий связи между СХД и серверами образуют так называемую SAN сеть. Отказоустойчивое подключение участников SAN сети подразумевает постоянное наличие хотя бы одного пути между инициатором (хост) и таргетом (СХД). Т.к. СХД сейчас практически поголовно имеют минимум два контроллера, каждый сервер должен иметь связь с каждым из них. В простейшем варианте серверы подключаются к СХД напрямую. Такой режим работы называют Direct Attach. СХД Qsan поддерживают такой режим работы. В этом случае каждый сервер должен иметь двухпортовую HBA для соединения с каждым контроллером СХД. Т.е. между сервером и СХД будет 2 пути. При наличии максимального количества опциональных портов в таком режиме к СХД можно подключить до 10 серверов через iSCSI или до 8 серверов через Fibre Channel.

В большинстве случаев серверы соединяются с СХД через коммутаторы. Для большей надежности их должно быть два (в общем случае их, конечно же, может быть больше, но это они все равно делятся на две группы – фабрики). Этим выполняется защита от выхода из строя самого коммутатора, линка и порта контроллера СХД/HBA. В этом случае каждый сервер и каждый контроллер СХД подключается к каждому коммутатору. Т.е. между каждым сервером и СХД будет 4 пути (в случае двух коммутаторов).

Важные замечания по поводу параметров SAN сети:

- Фабрики между собой не соединяются для изоляции в случае возникновения ошибок в сети;

- Если протокол iSCSI делит использование коммутаторов с другими сервисами, то весь трафик iSCSI должен быть помещен в изолированный VLAN;

- Для протокола Fibre Channel необходимо настроить в коммутаторах зонирование по принципу «один инициатор – один или несколько таргетов» для исключения взаимовлияния серверов друг на друга;

- Для iSCSI соединений со скоростью 10G и выше рекомендуется включить поддержку кадров большого размера (MTU=9000) с целью увеличения производительности. Важно помнить, что необходимо изменить MTU у всех участников сети: порты контроллера СХД, физические коммутаторы, виртуальные коммутаторы vSwitch, порты vKernel.

Для Qsan параметр MTU меняется на каждом порту каждого контроллера в меню iSCSI Ports

Для ESXi параметр MTU меняется у vSwitch: хост → Configure → Virtual Switches → Edit для конкретного коммутатора

Для vKernel параметр MTU меняется хост → Configure → Virtual Switches → Edit Settings для конкретного порта

Для получения инструкций по изменению MTU у физических коммутаторов рекомендуем обратиться к документации конкретного производителя.

Действия на стороне СХД

Необходимые настройки на СХД можно разделить на два этапа:

- Настройка интерфейсов

- Настройка пространства хранения

Настраивать интерфейсы требуется в основном в случае использования протокола iSCSI: необходимо задать IP адреса портов на вкладке iSCSI Ports. IP адреса портов должны быть из разных подсетей, чтобы однозначно маршрутизировался трафик на стороне хоста.

В случае использования интерфейса Fibre Channel ничего настраивать, как правило, не нужно.

Далее необходимо создать пространство хранения. Сначала создается пул – группа физических накопителей, работающих совместно. Пулов в пределах СХД может быть несколько. Накопители внутри пула объединяются в соответствии с выбранным при его создании уровнем RAID, обеспечивая заданную надежность. Пулы создаются на вкладке Pools → Create Pool, где запускается пошаговый мастер.

- Необходимо выбрать тип пула: thick (место выделяется сразу) или thin (место выделяется по мере заполнения). Отметим, что thick пулы являются более производительными.

- Выбрать конкретные диски

- Уровень RAID

- Указать параметры физических накопителей, влияющие на их производительность. Рекомендуется использовать установки по умолчанию для максимальной скорости:

- Enable Disk Write Cache

- Enable Disk Read-ahead

- Enable Disk Command Queuing

- Disable Disk Standby

![]()

![]()

![]()

![]()

Помимо обычных пулов Qsan поддерживает создание AutoTiering пулов при условии активации соответствующей лицензии. С принципом работы таких пулов можно ознакомиться в отдельной статье.

После создания пула(ов) необходимо создать тома (volume): Volumes → Create volumes. Также запустится пошаговый мастер создания тома.

![]()

![]()

Необходимо задать требуемый размер тома, тип тома выбирается как RAID volume. На свойствах остановимся подробнее.

- Block Size – размер блока, который будет эмулироваться для хоста. Для ESXi он должен быть 512 байт в силу требований VMware. В противном случае такой диск нельзя будет подключить к ESXi. СХД не сможет установить размер блока меньше, чем у физических накопителей. Поэтому нельзя использовать в СХД диски с разметкой 4Kn (блок 4КБ) совместно с VMware. Требуются накопители 512n или 512e.

- Background I/O Priority – приоритет фоновых задач (расширение, миграция и пр.)

- Erase Volume Data – необходимость зануления создаваемого тома. Значение Fast Erase соответствует записи нулей в первый гигабайт пространства, может быть полезно при повторном использовании дисков с целью удалить остатки предыдущих данных (стереть таблицы размещения). Full Erase – запись нулей по всему объему, полезно для достижения максимальной производительности в случае использования RAID 1/10.

- Enable Cache Mode (Write-back Cache) – включение кэша СХД. Очень сильно влияет на производительность.

- Enable Video Editing Mode – снижение производительности ради более стабильных результатов. Для использования совместно с VMware лучше выключить.

- Enable Read-ahead – включение упреждающего чтения. Положительно влияет на производительность.

- Enable Fast RAID Rebuild – при активации данной настройки система будет вести трекинг всех записываемых блоков, чтобы понимать, сколько реальных данных записано на том. В случае выхода из строя диска в составе RAID группы во время ребилда не будут копироваться пустые блоки, что может ускорить данный процесс. Однако стоит помнить, что использование Fast Rebuild снижает производительность при случайном доступе.

Заключительным этапом в настройке СХД является публикация томов для доступа к ним со стороны хостов через функционал LUN mapping → Map LUN.

![]()

![]()

- Необходимо выбрать протокол доступа: FCP (Fibre Channel) или iSCSI. Доступ к одному и тому же тому может быть только через один протокол.

- Allowed Host – список хостов, которым разрешен доступ к тому. По умолчанию разрешено всем (*). Однако рекомендуется всегда явно указывать разрешения для исключения конфликтов доступа и, соответственно, повреждения файловой системы. Для Fibre Channel указываются WWPN хостов (с возможностью выбора из всех доступных в SAN сети). Для iSCSI указываются IQN хостов. В случае нескольких хостов они добавляются по кнопке Add Host. Со стороны ESXi значения WWPN и IQN можно узнать на вкладке Хост → Configure → Storage adapters

![]()

- LUN – ID с которым том будет виден хостам. Также по этому идентификатору легко опознать том со стороны сервера. Для корректной работы кластера VMware LUN ID должен быть одинаковым для одного и того же тома для всех узлов кластера.

Действия на стороне хоста

При использовании протокола iSCSI необходимо выполнить:

- один раз добавить Software iSCSI адаптер, если этого не было сделано ранее: Хост → Configure → Storage adapters → Add Software Adapter.

- Создать отдельные vKernel для работы с iSCSI (минимум два – для связи с каждым контроллером СХД). Можно подключить их на существующий vSwitch, но желательно подключить на отдельный, не имеющий Port Group с виртуальными машинами с целью упрощения администрирования. У данного vSwitch должно быть минимум 2 физических линка для отказоустойчивости. vKernel следует назначить IP адреса из разных подсетей, чтобы хост мог однозначно маршрутизировать трафик. Также очень важно для каждого vKernel изменить параметр Failover таким образом, чтобы он использовал только один физический линк, т.к. VMware не поддерживает Teaming для iSCSI. В итоге должно получиться следующее:

Установки Failover меняются через изменение настроек Port Group

![]()

![]()

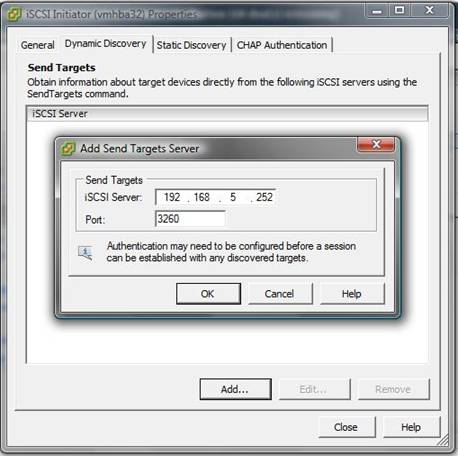

- В свойствах Software iSCSI Initiator необходимо указать адреса таргетов, т.е. СХД на вкладке Dynamic Discovery должны быть введены все используемые IP адреса контроллеров СХД

![]()

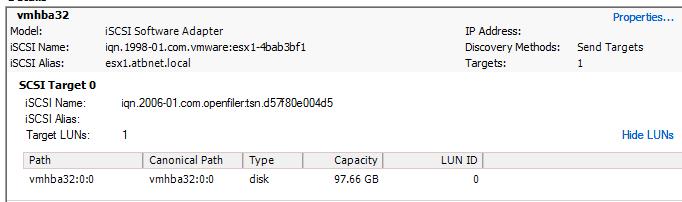

- После любого изменения параметров СХД и SAN сети необходимо выполнить Rescan: Хост → Storage Adapter → Rescan Storage. Итогом будет появление (т.к. мы добавляем новый том) нового устройства, доступного по 4 путям (согласно топологии подключения через два коммутатора в Dynamic Discovery указано 4 IP адреса портов СХД) с LUN как мы и задавали при публикации на СХД.

![]()

При использовании протокола Fibre Channel все гораздо проще: достаточно выполнить Rescan для обнаружения нового тома. В нашем примере это том с LUN доступный по 4 путям (по 2 на каждом порту HBA).

Следующим шагом будет создание Datastore на новом томе: Хост → Actions → Storage → New Datastore.

По умолчанию VMware использует политику работы с многопутевыми устройствами как Most Recently User (MRU). Для большей эффективности и повышения производительности необходимо для каждого Datastore изменить политику на Round Robin, при которой все доступные пути до СХД будут использоваться равномерно. Политика меняется в меню Хост → Storage Devices → Наше Устройство → Properties → Edit Multi-Path. После применения политики Round Robin все пути будут использоваться для ввода/вывода (Active I/O).

![]()

![]()

В случае использования кластера из нескольких хостов ESXi действия, описанные выше, необходимо повторить на каждом из хостов кроме создания нового Datastore. Т.к. Datastore уже был создан ранее, он появится у остальных членов кластера после выполнения команды Rescan.

Эта статья о том, как подключить iscsi LUN c СХД к хосту Esxi.

Итак, надеюсь у вас уже есть LUN на СХД, который мы будем подключать к хосту esxi. Как создать LUN на СХД NetApp я уже описывал.

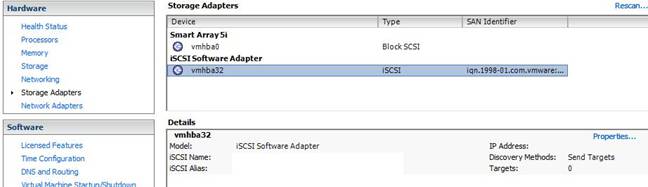

Прежде чем подключить iscsi LUN к хосту Esxi, нужно создать на хосте software iscsi адаптер. Для этого на вкладке «Storage Adapters» хоста esxi жмем «Add», чобы добавить scsi адаптер.

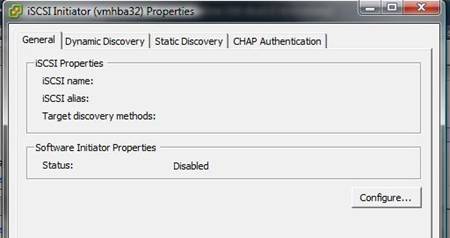

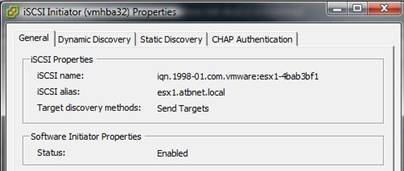

После этого, выбираем созданный нами адаптер и жмем «Properties». На этой вкладке вы можете видеть WWN адаптера, который понадобится при настройке доступа к LUN на СХД.

![vmware-kak-podklyuchit-iscsi-lun-c-sxd-k-xostu-esxi_Image-023-2]()

На открывшемся экране, на вкладке «General Properties» можно указать понятный алиас для нашего инициатора.

На вкладке «Network Configuration» добавляем сетевой адаптер, который будет использоваться для передачи iscsi трафика. Жмем «Add»

![vmware-kak-podklyuchit-iscsi-lun-c-sxd-k-xostu-esxi_Image-025-2]()

и выбираем нужный интерфейс.

![vmware-kak-podklyuchit-iscsi-lun-c-sxd-k-xostu-esxi_Image-029-1]()

На вкладке «Dynamic Discovery» указываем IP адрес нашей СХД.

![vmware-kak-podklyuchit-iscsi-lun-c-sxd-k-xostu-esxi_Image-027-2]()

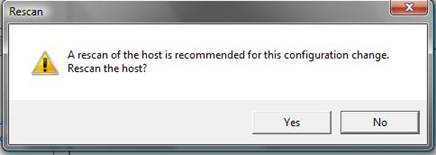

После этого необходимо пересканировать все storage адаптеры на хосте.

![vmware-kak-podklyuchit-iscsi-lun-c-sxd-k-xostu-esxi_Image-030-1]()

После этого вы увидите в списке доступных устройств ваш LUN.

![vmware-kak-podklyuchit-iscsi-lun-c-sxd-k-xostu-esxi_Image-042-1]()

Теперь необходимо добавить storage на хост. Для этого на вкладке «Storage» жмем «Add Storage».

![vmware-kak-podklyuchit-iscsi-lun-c-sxd-k-xostu-esxi_Image-043-1]()

В открывшемся окне выбираем «Disk/LUN» и жмем «Next».

![vmware-kak-podklyuchit-iscsi-lun-c-sxd-k-xostu-esxi_Image-044-1]()

Выбираем наш LUN.

![vmware-kak-podklyuchit-iscsi-lun-c-sxd-k-xostu-esxi_Image-045]()

Выбираем тип файловой системы.

![vmware-kak-podklyuchit-iscsi-lun-c-sxd-k-xostu-esxi_Image-046]()

На следующем экране жмем «Next».

![vmware-kak-podklyuchit-iscsi-lun-c-sxd-k-xostu-esxi_Image-047]()

Далее выбираем имя для нашего Storage.

![vmware-kak-podklyuchit-iscsi-lun-c-sxd-k-xostu-esxi_Image-048]()

Выбираем объем доступного пространства.

![vmware-kak-podklyuchit-iscsi-lun-c-sxd-k-xostu-esxi_Image-049]()

На заключительном экране жмем «Finish» и ждем завершения создания хранилища.

![vmware-kak-podklyuchit-iscsi-lun-c-sxd-k-xostu-esxi_Image-050]()

После этого вы можете видеть добавленное хранилище в списке доступных для размещения виртуальных машин.

![vmware-kak-podklyuchit-iscsi-lun-c-sxd-k-xostu-esxi_Image-033-1]()

Вот так можно добавить iscsi LUN к хосту Esxi.

О том, как правильно отключить datastore(LUN) от хоста(кластера) написано здесь.

27.04.2021![date]()

VMWare, Виртуализация![directory]()

Комментариев пока нет![comments]()

В VMware vSphere вы можете использовать iSCSI диски в качестве общего дискового хранилища для ваших ESXi хостов. ESXi хост получает доступ к таким дискам по вашей локальной сети с помощью протокола TCP. В этой статье мы рассмотрим, как подключить iSCSI LUN с вашей СХД (или сервера) к хосту VMWare ESXi и создать на нам общее VMFS хранилище.

Предполагаем, что вы создали, настроили и опубликовали iSCSI таргет (диск) на вашей СХД (в Windows Server вы можете в качестве iSCSI таргет использовать виртуальный vhdx диск).

На СХД убедитесь, что вы разрешили подключение к вашему iSCSI таргету вашим ESXi хостам (iSCSI инициаторы). Доступ можно получить по IQN (как получить IQN iSCSI адаптера в ESXi показано ниже, по DNS имени, IP или MAC адресу.В данном примере мы используем отдельно стоящий хост с ESXi 6.7 (можно использовать и бесплатный ESXi Hypervisor). Это может быть физический хост или виртуальная машина (например, вот пример использования ESXi с помощью nested virtualization в Hyper-V). На хосте есть два сетевых интерфейса (один будет использоваться для управления, второй для трафика к iSCSI LUN).

Настройка сети для iSCSI трафика в VMWare ESXi

Сначала нужно создать отдельный VMkernel сетевой интерфейс, который будет испоьзоваться ESXi хостом для доступа к iSCSI хранилищу. Перейдите в раздел Networking -> VMkernel NICs -> Add VMkernel NIC.

![добавить vmkernel порт в esxi]()

Кроме vmk порта нужно сразу создать новая группа портов (New port group). Укажите имя для этой группы – iSCSI и назначьте статический IP адрес для вашего интерфейса vmkernel.

![vmk порт для iscsi трафика в esxi]()

Теперь перейдите в настройки вашего стандартного коммутатора vSwitch0 (Networking -> Virtual Switches). Проверьте, что второй физический интерфейс сервера vmnic1 добавлен в конфигурацию и активен (если нет, нажмите кнопку Add uplink и добавьте его).

![добавить uplink в vmware esxi]()

Проверьте в секции Nic Teaming что оба физических сетевых интерфейса находятся в статусе Active.

![активные uplink сетевые адаптеры]()

![отключить management аплинк для iscsi port groups]()

В результате ваш ESXi хост будет использовать для доступа к вашему iSCSI LUN только один интерфейс сервера.

Настройка программного iSCSI адаптера в VMWare ESXi

По умолчанию в ESXi отключен программный адаптер iSCSI. Чтобы включить его, перейдите в раздел Storage -> Adapters. Нажмите на кнопку Software iSCSi.

![включить software iscsi в vmware esxi]()

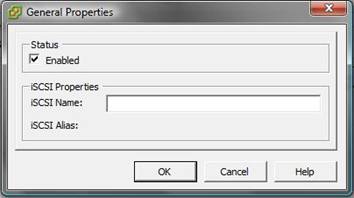

Измените iSCSI enable на Enabled.

Обратите внимание, что здесь также указан IQN вашего iSCSI адаптера(инициатора), который можно использовать при настройке доступа к iSCSI LUN на СХД).Затем в секции Dynamic targets добавьте IP адрес вашего iSCSI хранилища и порт подключения (по-умолчанию для iSCSI трафика используется порт TCP 3260). ESXi просканирует все iSCSI таргеты на этом хосте и выведет их в списке Static Targets.

Здесь же можно настроить CHAP аутентификацию, но в тестовой среде это не обязательно.![список доступных iscsi таргетов с esxi хоста]()

Сохраните настройки. Обратите внимание, что на вкладке Storage -> Adapters появился новый HBA vmhba65 типа iSCSI Software Adapter.

Если ESXi хост подключен к vCenter, чтобы добавить iSCSI LUN, перейдите в раздел Configure -> Storage –> Storage Adapters. Выберите Software iSCSI adapter и укажите на вкладке Dynamic Discovery имя или IP адрес вашего iSCSI хранилища. Выполните Rescan. Список доступных iSCSI таргет должен появится на вкладке Static Discovery.![vmhba65 типа iSCSI Software Adapter]()

![добавление iscsi хранилиза в esxi]()

Если вы не видите список iSCSI таргетов на СХД, можно продиагностировать доступность iSCSI диска через консоль ESXi.

Включите на ESXi хосте SSH и подключитесь к нему с помощью любого SSH клиента (я использую встроенный SSH клиент Windows 10)

С помощью следующей команды можно выполнить проверку доступности вашего iSCSI хранилища (192.168.13.10) с указанного vmkernel порта (vmk1) :

![vmkping проверка доступности СХД]()

В этом примере iSCSI хранилище отвечает на ping.

Теперь нужно проверить, что на хранилище доступен iSCSI порт TCP 3260 (в этом примере 192.168.13.60 это IP адреса интерфейса vmk1):

![esxi shell проверка доступности iscsi порта 3260]()

Проверьте, что на хосте включен программный iSCSI:

Если нужно, включите его:

Также можно получить текущие параметры программного HBA адаптера iSCSI:

![esxcli iscsi adapter get]()

Создаем VMFS хранилище на iSCSI LUN в VMWare ESXi

Теперь на доступном iSCSI диске можно создать VMFS (Virtual Machine File System) хранилище для размещения файлов виртуальных машин.

Перейдите в раздел Storage -> Datastores -> New datastore.

![создать новое хранилище на iscsi LUN]()

Задайте имя VMFS хранилища и выберите iSCSI LUN, на котором его создать.

![создать vmfs датастору на iscsi диске]()

Выберите тип файловой системы VMFS 6 и укажите, что для хранилища нужно использовать весь объем iSCSI диска. Через несколько секунд новое VMFS хранилище станет доступно из ESXi.

Если на данном LUN уже создано VMFS хранилище, оно сразу появится в списке доступных Storage Devices хоста.![новое vmfs хранилище для размещеия файлов виртуальных машин esxi]()

![msft iscsi disk в vmware esxi]()

Итак, вы подключили iSCSI диск к вашему ESXi хосту и создали на нем VMFS хранилище. Это хранилище могут одновременно использовать несколько ESXi серверов. Теперь у вас есть общее хранилище, и если вы настроите VMware vCenter server, вы сможете использовать vMotion для перемещения запущенных ВМ между хостами.

Для работы таких «вкусных» технологий VMWare, таких как HA, DRS, VMotion и Storage VMotion, необходимо общее SAN хранилище, и одной из технологий сетевой организации такого типа хранилищ является iSCSI SAN.

В данной статье рассмотрим базовые настройки, необходимые для подключения и использования iSCSI SAN на вашем ESX хосте.

В случае, если вы планируете использовать CHAP аутентификацию, то с расширенными настройками iSCSI хранилищ можно познакомится в статье Настройка iSCSI Storage (Advanced CHAP ).

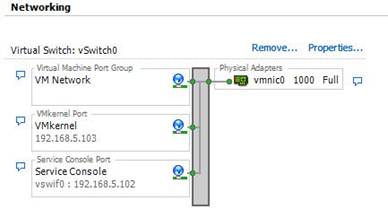

1. Во-первых вам необходимо убедится в том, что у вас есть порт VMkernel. Если на вашем виртуальном коммутаторе (vSwitch) такого порта нет, необходимо его создать, для чего познакомьтесь со статьей « Создаем порт VMkernel ».

По умолчанию на хосте ESX создается 2 группы портов(port group): для виртуальных машин (Virtual Machine) и для сервис консоли (Service Console).

![]()

2. Теперь адаптер устройства хранения нужно настроить. Это программный адаптер iSCSI, заметьте, что использование софтварного (программного) iSCSI добавляет дополнительные накладные вычислительные расходы на сервер.

![]()

![]()

![]()

6.Также будут созданы имя iSCSI инициатора и его псевдоним (alias).

![]()

![]()

10. Появится окно с предложение выполнить рескан (rescan). Нажмите Yes.

![]()

11. В результате вы увидите все настройки ISCSI адаптера и список всех доступных LUN на хосте SAN.

![]()

12. Теперь нам осталось создать хранилище VMFS datastore (статья Создаем VMFS Datastore ) или же RDM (статья Подключаем диск типа raw device mapping (RDM)).

Первоначальную настройку FreeNAS мы проделали в предыдущей статье.

В этой части настроим FreeNAS. Во второй части - WMware ESXi.

Для этого, залогинимся на сервере и произведем следующие настройки.

Заходим в службы и выбираем iSCSI. ( По умолчанию выключено.)![Подключение FreeNAS iSCSi диска к VMware ESXi]()

Базовое имя подставится само. Аутентификация нам не нужна (VMware и FreeNAS находятся в отдельной подсети и никто чужой туда доступа не имеет. Поэтому ставим "Авто". Таймауты оставляем по умолчанию.

![Подключение FreeNAS iSCSi диска к VMware ESXi]()

Теперь необходимо настроить порталы, т.е ввести номер метки и адрес сервера FreeNAS с портом для работы протокола iSCSi по-умолчанию. Иначе говоря : по какому IP адресу и порту работает сервер.

![FreeNAS iSCSi диск и VMware ESXi]()

Добавляем инициаторов - тех, кто можем коннектиться к FreeNAS.

Я просто описал подсеть. Обязательно должен быть указан номер метки.![FreeNAS iSCSi диск и VMware ESXi]()

Описываем Цели. По-русски говоря, где на сервере FreeNAS лежат данные.

Сначала создаем экстент, тип выбираем "файл". Указываем путь на сервере и размер файла.

Внимание , при указании пути директории должны быть созданы. ( В данном случае директория /mnt/).![FreeNAS iSCSi диск и VMware ESXi]()

А теперь добавляем цель. (Связываем экстент с файловой системой хранилища.)

Имя цели - dsk0

Тип- диск

флаги - RW (обязательно RW, иначе не сможем создавать снапшоты)

группа порталов и инициаторов - согласно их меткам (1).

Хранилище , и т.д.![FreeNAS iSCSi диск и VMware ESXi]()

Настройку FreeNAS на этом закончили.

В этой части рассмотрим настройку VMware ESXi к FreeNAS по протоколу iSCSi.

Сначала добавим сетевую карту, по которой VMware ESXi будет общаться с FreeNAS.

Логинимся на VMware.![Подключение FreeNAS iSCSi диска к VMware ESXi]()

Заходим в хост - Configuration-Networking.

Видим только настроенную карту (vmnic0) локальной сети предприятия ip -10.10.10.65

Далее выбираем вверху Virtual Switch и Properties.

Попадаем на вкладку Ports. С нее переходим на вкладку Network Adapters и нажимаем Add.

![Подключение FreeNAS iSCSi диска к VMware ESXi]()

Видим адаптер vmnic1 со скоростью 1000Full (предварительно эта сетевая карта была соединена с помощью кросс кабеля с сетевой картой FreeNAS.) и выбираем его с помощью галочки.

![Подключение FreeNAS iSCSi диска к VMware ESXi]()

Т.к. Failover нам не нужен делаем оба сетевых интерфейса активными.

![Подключение FreeNAS iSCSi диска к VMware ESXi]()

Жмем Finish.

![FreeNAS iSCSi диск и VMware ESXi]()

После добавления интерфейса не забываем назначить ему Ip адрес для возможности работы с freenas.

Как это делается смотрите в предыдущих статьях.Необходимо разрешить и настроить работу по iscsi.

Идем в Configuration- Storage Adapter. Выбираем ISCSI Software Adapter - Properties.![FreeNAS iSCSi диск и VMware ESXi]()

![FreeNAS iSCSi диск и VMware ESXi]()

По умолчанию iSCSi adapter запрещен. Жмем Configure button и выбираем Enable,Ok

Идем на вкладку Dynamic Discovery, выбираем Properties. Жмем добавить. Добавляем IP адрес сервера и порт.

![FreeNAS iSCSi диск и VMware ESXi]()

Идем в Static Discovery и проверяем, видно ли FreeNAS

![FreeNAS iSCSi диск и VMware ESXi]()

![FreeNAS iSCSi диск и VMware ESXi]()

Далее займемся настройкой для подключения к хранилищу.

Переходим к Storage. Видим локальное хранилище datastore1.

Далее Add Storage - Disk/LUN - Next.Читайте также: