Настройка игры разгон aoc монитор

год назад покупал родителям супер-бюджетный моник AOC I2381FH

в характеристиках указана макс. герцовка 76 Гц

В панели управления nVidia нет режима 75/76 Гц, есть только стандартная 60 Гц

Допускаю мысль, что если бы была возможность подключить моник через DVI кабель, то были бы заветные 75 Гц, но в монике только 2 разъема VGA (устаревший) и HDMI (цифровой). Короче, подключен по HDMI

В настройках nVidia можно установить пользовательский режим с любым значением герцовки, но перед этим высвечивается предупреждение мол вы действуете на свой страх и риск бла-бла.

Знаю, что если разгонять, то надо герцовку увеличивать постепенно, чтобы найти максимум без косяков в отображении картинки.

Вопросов несколько:

1) опасно ли разгонять моник подключенный по HDMI (или максимум, который способен пропускать этот кабель равен 60 Гц)?

2) как сильно разогнанный монитор будет исчерпывать свой ресурс? может ли он испортиться спустя пол-года работы, например.

п.с. просьба отписывать по этим двум вопросам только опытным юзерам кто в этом шарит, кто сталкивался с подобным и для кого герцовка решает.

Дополнительный вопрос:

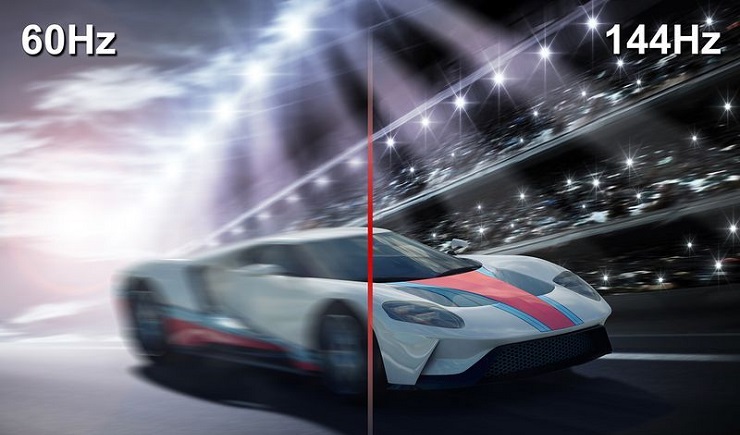

курсор в доте на этом монике какой-то не плавный (прерывистый, как будто 15-20 фпс в игре), у всех с 60 Гц мониками такое? или это как-то фиксится? или это потому что я привык к 144 герцам? втф вообще?!

Но ведь разницы между 60 и 75 горцами ты не увидишь глазом

Но ведь разницы между 60 и 75 горцами ты не увидишь глазом

просьба отписывать по этим двум вопросам только опытным юзерам кто в этом шарит

год назад покупал родителям супер-бюджетный моник AOC I2381FH

в характеристиках указана макс. герцовка 76 Гц

В панели управления nVidia нет режима 75/76 Гц, есть только стандартная 60 Гц

Допускаю мысль, что если бы была возможность подключить моник через DVI кабель, то были бы заветные 75 Гц, но в монике только 2 разъема VGA (устаревший) и HDMI (цифровой). Короче, подключен по HDMI

В настройках nVidia можно установить пользовательский режим с любым значением герцовки, но перед этим высвечивается предупреждение мол вы действуете на свой страх и риск бла-бла.

Знаю, что если разгонять, то надо герцовку увеличивать постепенно, чтобы найти максимум без косяков в отображении картинки.

Вопросов несколько:

1) опасно ли разгонять моник подключенный по HDMI (или максимум, который способен пропускать этот кабель равен 60 Гц)?

2) как сильно разогнанный монитор будет исчерпывать свой ресурс? может ли он испортиться спустя пол-года работы, например.

п.с. просьба отписывать по этим двум вопросам только опытным юзерам кто в этом шарит, кто сталкивался с подобным и для кого герцовка решает.

Дополнительный вопрос:

курсор в доте на этом монике какой-то не плавный (прерывистый, как будто 15-20 фпс в игре), у всех с 60 Гц мониками такое? или это как-то фиксится? или это потому что я привык к 144 герцам? втф вообще?!

Привык к монику, не трать время ради 15 гц

зачем тебе 75гц, разгоняй уже до 144гц

год назад покупал родителям супер-бюджетный моник AOC I2381FH

в характеристиках указана макс. герцовка 76 Гц

В панели управления nVidia нет режима 75/76 Гц, есть только стандартная 60 Гц

Допускаю мысль, что если бы была возможность подключить моник через DVI кабель, то были бы заветные 75 Гц, но в монике только 2 разъема VGA (устаревший) и HDMI (цифровой). Короче, подключен по HDMI

В настройках nVidia можно установить пользовательский режим с любым значением герцовки, но перед этим высвечивается предупреждение мол вы действуете на свой страх и риск бла-бла.

Знаю, что если разгонять, то надо герцовку увеличивать постепенно, чтобы найти максимум без косяков в отображении картинки.

Вопросов несколько:

1) опасно ли разгонять моник подключенный по HDMI (или максимум, который способен пропускать этот кабель равен 60 Гц)?

2) как сильно разогнанный монитор будет исчерпывать свой ресурс? может ли он испортиться спустя пол-года работы, например.

п.с. просьба отписывать по этим двум вопросам только опытным юзерам кто в этом шарит, кто сталкивался с подобным и для кого герцовка решает.

Дополнительный вопрос:

курсор в доте на этом монике какой-то не плавный (прерывистый, как будто 15-20 фпс в игре), у всех с 60 Гц мониками такое? или это как-то фиксится? или это потому что я привык к 144 герцам? втф вообще?!

На указанные вопросы отвечать не буду так как они изначально не верны. VGA хоть и устаревший интерфейс, но поддерживает 75 гц, это проверено многолетним опытом использования такого монитора.

Если в штатных характеристиках указан, а в ПУ нет - это не значит что монитор не может работать так или не должен. Тут уже нужен опыт больший моего, но всего лишь на одну страницу текста. Предположу что дело в некой малой несовместимости или заводском блоке настроек. Энивей - через ПУ можно переключить.

Косательно износа - при штатных условиях эксплуатации износ будет тот же самый, как и было задумано. Другое дело что старые мониторы изначально изношены и может появится проблема, которая проявилась бы и при 60гц. Мой за годы работы чинился трижды, все три раза проблема была в блоке питания.

Ваш монитор является неотъемлемой частью вашей игровой системы. Тем не менее, важную роль монитора всегда недооценивали, поскольку мониторы часто имеют собственные отдельные элементы управления. Но те дни, когда вам приходилось настраивать функции монитора с помощью неудобных кнопок прошли. Мы с гордостью представляем AOC G-Menu, приложение «все в одном», которое позволяет полностью контролировать монитор непосредственно с компьютера с помощью клавиатуры и мыши.

Что такое AOC G-Menu?

AOC G-Menu – это инструмент, который можно установить на ПК для полноценной настройки в сочетании с максимальным удобством для любого монитора AOC или AGON, используя ряд полезных функций:

- Режимы игры: AOC G-Menu предлагает три различных режима, которые предварительно оптимизированы для FPS, RTS и гоночных игр, их можно активировать для улучшения игрового процесса одним щелчком мыши.

- Регулируемые пользователем режимы: если вам не понравились предварительно оптимизированные настройки, вы можете создать свой режим, устанавливая каждую настройку монитора в соответствии с вашими потребностями, а затем сохранить этот режим в одном из трех слотов. Эти режимы можно менять одним движением руки.

- Синхронизация игры (Game Sync): определенные игры требуют определенных настроек, а благодаря функции Game Sync настройки теперь будут автоматически привязаны к игре. Выберите различные настройки для различных приложений и Game Sync автоматически применит необходимые настройки при запуске соответствующего приложения.

- Режимы LowBlue: длительные игровые сессии могут оказывать отрицательное влияние на глаза. Режимы LowBlue смягчают воздействие синего света, излучаемого монитором, чтобы ваши глаза могли отдохнуть.

- Light FX: если ваш монитор поддерживает световые эффекты, теперь ими можно управлять с помощью клавиатуры и мыши, используя AOC G-Menu.

- Экономичные режимы: активируйте экономичные режимы для экономии энергии. Вы даже можете автоматически активировать режим на заранее определенный период времени. При необходимости вернитесь к игровой сессии, активируя необходимый режим игры.

- Экран: AOC G-Menu позволяет легко и просто управлять настройками мониторов, где бы вы ни находились.

Уверен, многие из вас хотели бы себе 144 герцовый монитор, но их стоимость не всем по карману. Многие слышали или смотрели гайды на Youtube о том как поднять герцовку – "разогнать монитор" на стационарном ПК через панель Nvidia или через другие программы (CRU), которые мало того что не у всех работают, так после повышения герцовки (частоты обновления монитора) некорректно отображают цвета. Выставляется неверное разрешение экрана, возникает куча разных мыльных и мерцающих эффектов.

Я расскажу вам как повысить герцовку монитора не только на ПК, но и на ноутбуке, без риска спалить монитор или вызывать артефакты. Информации о том, как это сделать на ноуте, я не нашел во всем интернете. Я также пробовал программу для разгона монитора CRU, но после применения нужных значений она сбрасывает их почти сразу.

В общем, мне удалось поднять частоту экрана на своем ноутбуке MSI с 60-ти до 100!

Теперь в Warface можно выбрать более 60-ти ГЦ, разница колоссальная. На разрешении немного ниже родного значение ГЦ выросло до 120.

Так как в панели Nvidia на ноутбуках отсутствует параметр настройки пользовательских разрешений, в котором и находится возможность выставить герцовку выше той, что у вас уже есть, нужно совершенно другое решение.

[h3]Как повысить количество герц на экране ноутбука или ПК[/h3]

Действия проводились на ноутбуке c Windows 10 на борту, и некоторые элементы могут отличаться. Например, обладателям только дискретной видеокарты не нужно дополнительно заходить в панель настроек Intel, достаточно сделать все настройки в параметрах Windows.

1. Для начала проверьте какая герцовка у вас установлена. Она должна быть 60 Гц.

Для этого зайдите в "Параметры экрана" (ПКМ на Раб. Столе) –> "Дополнительные параметры экрана" –> "Свойства графического адаптера" и откройте вкладку "Монитор". Там откройте пункт "Частота обновления экрана", проверьте количество Гц, которое может выдавать монитор. Если ваш монитор поддерживает больше 60, ставьте больше.

Если у вас значения в пределах 59-60 Гц, идем дальше.

2. Вновь зайдите в "Параметры экрана".

Рядом с основным экраном появится еще один (виртуальный), выделяем его кнопкой мыши.

В пункте "Несколько дисплеев" выбирайте, как показано на рисунке, и жмите применить.

В этом же пункте выбираем значение "Дублировать эти экраны" и жмём применить.

3. Дальше шаг для тех ,у кого процессор Intel с интегрированной видеокартой Intel HD 3000\4000 или подобной. Если у вас другой процессор или нет встроенной графики, то этот шаг можно пропустить.

Переходим в панель встроенной Intel видеокарты и выбираем параметр "Дисплей".

Выбираем дисплей в списке: по умолчанию установлен "Встроенный", нам нужно выбрать наш виртуальный "монитор".

Выставляем нужное нам разрешение (желательно родное разрешение вашего экрана) и выбираем в списке максимальную частоту ГЦ и применяем настройки.

Затем вверху нажимаем на стрелочку у надписи "Дисплей", выбираем в списке "Несколько дисплеев".

Дополнительные дисплеи --> в списке активных дисплеев выбираем главным наш виртуальный "Монитор" и применяем настройки.

4. Снова зайдите в параметры экрана, у вас должно показывать сдвоенный дисплей как на рисунке.

Заходим в дополнительные параметры экрана.

Свойства графического адаптера, и во вкладке "монитор" проверяем доступные частоты экрана.

Выбираем максимальное значение и применяем настройки.

PS: Иногда на ноутбуках нужно переключить дисплей нажатием на функциональные клавиши, или нажать проецировать (можно найти в панели уведомлений в трее, если развернуть все параметры).

1)

На этом все! Если вы всё сделали верно, то в свойствах экрана у вас будет доступно больше стандартных 60ГЦ, и в играх можно смело включать вертикальную синхронизацию. В тех играх, что поддерживают выбор частоты монитора, можно выбрать более 60-ти. Плавность картинки заметно прибавится, да и ощущения от игры будут более яркими!

Важно: Частоту в игре, да и вообще лучше ставить чуть меньше, чем выдает у вас FPS в игре, т.е частота монитора у вас должна быть на уровне с FPS или ниже. Если игра выдает 70-80 FPS, то 120 и более ГЦ ставить смысла нет, вы их не увидите, будет только хуже.Надеюсь, эта информация будет полезна многим, рад был ей поделиться с вами, друзья! Всем удачи на полях сражений.

Про то, что можно разогнать процессор, видеокарту или ОЗУ, слышали, я думаю, большинство пользователей ПК. Однако про то, что можно разогнать еще и монитор, знают немногие, причем зачастую разница от его разгона существеннее и заметнее, чем от разгона другого железа. Также она еще и безопаснее, но об этом ниже.

Теория

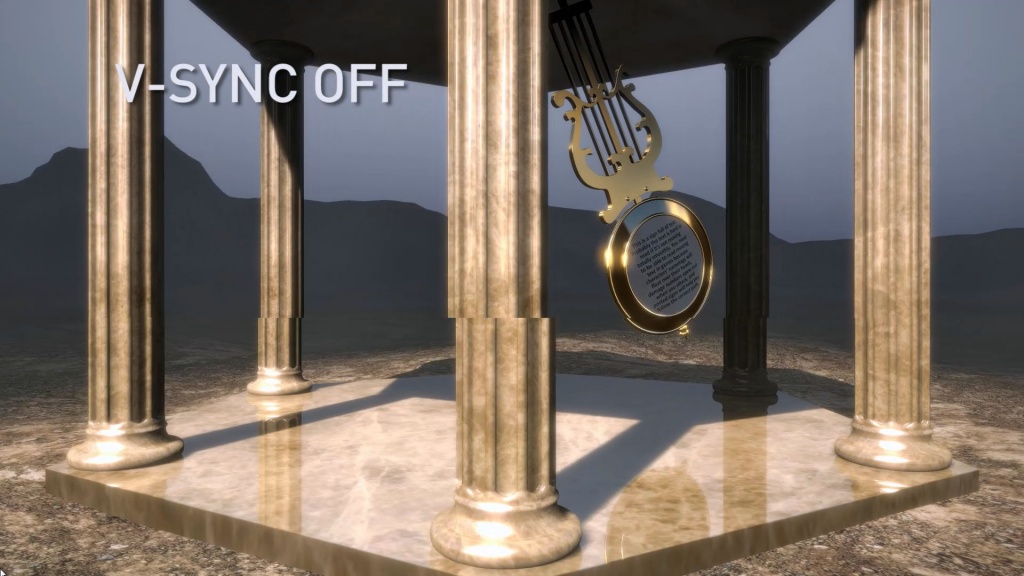

Для начала — что же подразумевается под разгоном матрицы монитора? Подразумевается увеличение частоты обновления монитора со стандартных 60 Гц и на сколько получится — 70-75, бывает и 120, и даже 150 Гц (!). Зачем это нужно? Чтобы повысить плавность картинки. Что означает, что частота обновления монитора — 60 Гц? Это означает, что картинка на экране меняется ровно 60 раз в секунду. При этом видеокарта может выдавать как меньшее количество fps, так и большее. Если количество кадров, выдаваемых видеокартой, меньше частоты обновления, то, значит, какой-то кадр будет дважды (а то и трижды) выведен на экран, что может привести к ощутимым задержкам. Если же количество кадров, выдаваемых видеокартой, больше частоты обновления монитора, то получится так, что на экран будет выдаваться сразу два-три кадра, что приведет к артефактам:

Компромиссом является установка вертикальной синхронизации. В чем ее суть? Она жестко привязывает один кадр, подготовленный видеокартой, к одному обновлению картинки на мониторе. И тут, если ваша видеокарта выдает стабильно больше кадров, чем частота обновления монитора, то вы получите идеальную плавную картинку, ну а ваша видеокарта при этом временами не будет загружена на 100% и будет отдыхать. И именно такой режим работы зачастую используется в системе — к примеру, когда вы скроллите в браузере, артефактов вы не видите, и при этом скроллинг плавный.

Поднятие частоты обновления монитора убивает сразу двух зайцев: во-первых, теперь вертикальная синхронизация будет идти на более высокой частоте, а значит плавность еще повысится (думаю, все видели разницу в роликах на YouTube с 30 и 60 кадрами? Вот тут также). Во-вторых, если ваша видеокарта в играх выдавала больше 60 кадров в секунду, то теперь порог появления артефактов отодвигается до новой частоты обновления, при этом информация на экране будет обновляться чаще, что достаточно важно для динамических игр.

Разумеется, возникает вопрос — насколько это безопасно? Гораздо безопаснее разгона железа: если монитор не может работать на заданной частоте, он просто не включится. Если на заданной частоте он заработал — значит, никаких проблем у вас не будет. Перегрев ему, как в случае с разгоном процессора или видеокарты, точно не грозит.

Практика

Теперь, когда немного разобрались с теорией, можно перейти к практике. Первое, что нужно знать — гонится любой монитор и даже матрицы ноутбуков, но тут есть сразу несколько сдерживающих факторов. Первый — это способ подключения: через DVI при разрешении 1920x1080 вы вряд ли получите свыше 65 Гц — сказывается достаточно низкая пропускная способность интерфейса. Через старые HDMI (до 1.4) при том же разрешении вы скорее всего сможете получить частоту около 75-85 Гц. Ну а через новые HDMI (1.4-2.0), Thunderbolt или DisplayPort ограничений практически нет — можно и 120-165 Гц получить. Аналогично зачастую нет ограничения у матриц ноутбуков, подключенных напрямую к плате. Второй сдерживающий фактор — сама матрица, вернее ее контроллер. Бывает, что даже с быстрым подключением при повышении частоты появляются некоторые артефакты изображения — увы, тут уже ничего не сделаешь, кроме как снижать частоту до последней стабильной.

Теперь поговорим о том, как разгонять. Владельцам видеокарт от Nvidia тут везет — для них алгоритм прост: нужно зайти в панель управления Nvidia, перейти на вкладку «Изменение разрешения», нажать на кнопку «Настройка», в открывшемся окне поставить галку на включении режимов, не поддерживаемых дисплеем, после чего нажать на кнопку «Создать собственное разрешение», и в открывшемся окне мы наконец-то получаем доступ к изменению частоты обновления:

Частоту стоит поднимать на 3-5 Гц, после чего нажимать на кнопку «Тест». Если никаких артефактов не появилось и изображение есть — поднимаете частоту еще выше. Как только появились артефакты или исчезло изображение — снижаете до предыдущей рабочей частоты, и дальше поднимаете уже по 1 Гц — в общем, тут все ровно как при обычном разгоне видеокарты. После того, как нашли нужную частоту обновления, просто сохраняете полученную конфигурацию, и она появится в пользовательских разрешениях.

Как видите, тут риска никакого — если монитор «не завелся» на указанной вами частоте, через 20 секунд система откатит значение частоты на дефолтное. Увы — все так хорошо только с видеокартами от Nvidia, с видеокартами от AMD или Intel все хуже — там в настройках драйвера частоту увеличить нельзя, однако есть универсальное приложение, которое поможет это сделать — называется оно Custom Resolution Utility (CRU), скачать его последнюю версию можно тут.

Сразу предупрежу — проблема программы в том, что у нее нет кнопки Тест, как в случае с Nvidia, поэтому частоты применяются сразу и бесповоротно. Так что если после выставления частоты вы видите черный экран — вам поможет или подключение второго монитора и возврат настроек на дефолтные, или же заход через безопасный режим и проделывание того же самого.

Работать с программой достаточно просто — вы ее запускаете, удаляете все разрешения из стандартных и снимаем все галочки слева (у себя я этого проделывать не буду, ибо уже разогнал матрицу через настройки Nvidia):

Теперь под окном с Detailed resolutions нажимаем на кнопку Add, выставляем Automatic - LCD Reduced и ниже меняем частоту обновления:

Тут принцип тот же — увеличиваем частоту на 3-5 Гц, нажимаем ОК, все сохраняем и перезагружаемся. Теперь заходим в панель AMD (или Intel) и выставляем новую частоту:

Вот, в общем-то, и все — как видите, ничего трудного или опасного нет.

Ну и остается последний вопрос — раз разгоняются почти все матрицы, то почему этого не делают производители с завода? Тут все просто: есть такое понятие, как стандарт, и для частоты обновления мониторов он уже достаточно давно составляет 60 Гц. Поэтому производители, даже если матрица способна работать на 70-80 Гц, все равно ограничивают ее частоту на стандартных 60 Гц. Во-вторых — зачастую все упирается уже в способ подключения. К примеру, передать 1080р60 можно по любому интерфейсу, хоть DVI, хоть Thunderbolt 3. А вот для 1080р80 уже нужен специальный кабель — DVI и старые HDMI уже не подходят. И чтобы не создавать путаницу, производители опять же ограничились 60 герцами.

Что касается вопроса, разгонять или не разгонять — решать вам и только вам. Если у вас получилось увеличить частоту с 60 до 65 Гц — то смысла в таком разгоне нет, разницу вы не увидите. А вот при разгоне уже до 75 и выше Гц разница становится явно видной, так что игра тут стоит свеч. Также следует учитывать, что после разгона повысится нагрузка на видеокарту при обычной работе — ведь ей теперь придется выдавать больше кадров в секунду, так что если вы разгоняете матрицу на ноутбуке — следует учитывать, что у вас несколько снизится время автономной работы.

Читайте также: