Windows server 2016 не видит raid

Как настроить RAID 1 массив и установить на него Windows 7, 8.1, 10

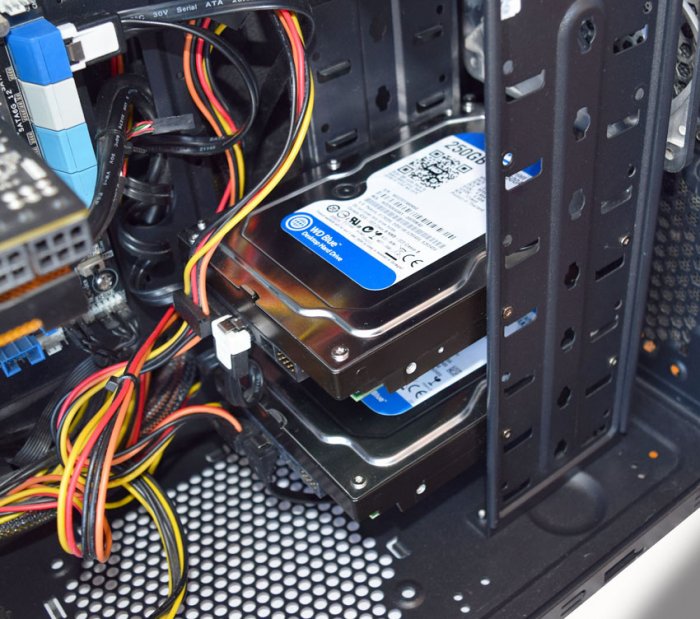

После прочтения предыдущих статей о создании программного RAID 1 массива средствами операционной системы вы конечно зададите вопрос: «А как установить саму систему на RAID 1 массив или может существует возможность переноса уже готовой и настроенной Windows с программами на рейд массив. Ведь неожиданно сломаться может и винчестер с установленной операционкой, а не только второстепенный жёсткий диск с файлами?» Потеря операционной системы со всеми установленными приложениями, при отсутствии резервной копии, может вывести из работы на несколько дней любую организацию, поэтому я считаю обязательным создание RAID 1 массива на рабочем месте и установки на него Windows.- Примечание : Друзья, кроме RAID 1 массива, ещё существует RAID 0 массив, способный увеличить быстродействие Вашей операционной системы в два раза .

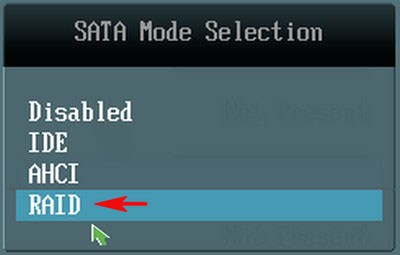

SATA Mode Selection выставляем в положение RAID.

HotPlug — (горячее подключение) выставляем в Enabled для жёстких дисков объединяемых в массив.

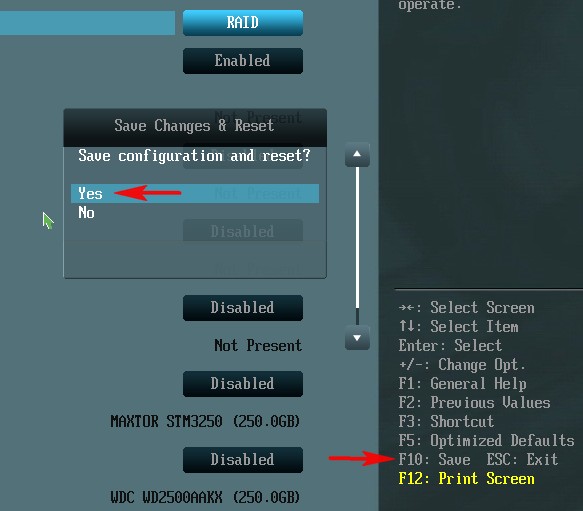

Для сохранения внесённых изменений жмём F10 и выбираем Yes. Происходит перезагрузка.

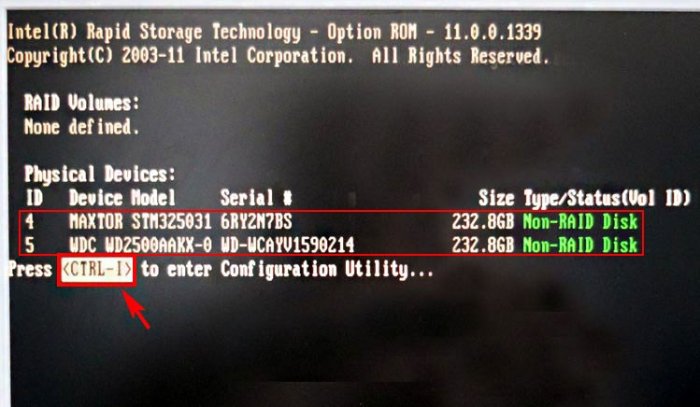

После включения в БИОС технологии RAID, на экране монитора при загрузке на несколько секунд возникнет предложение нажать клавиатурное сочетание ( CTRL-I ), чтобы войти в настройки конфигурации RAID.

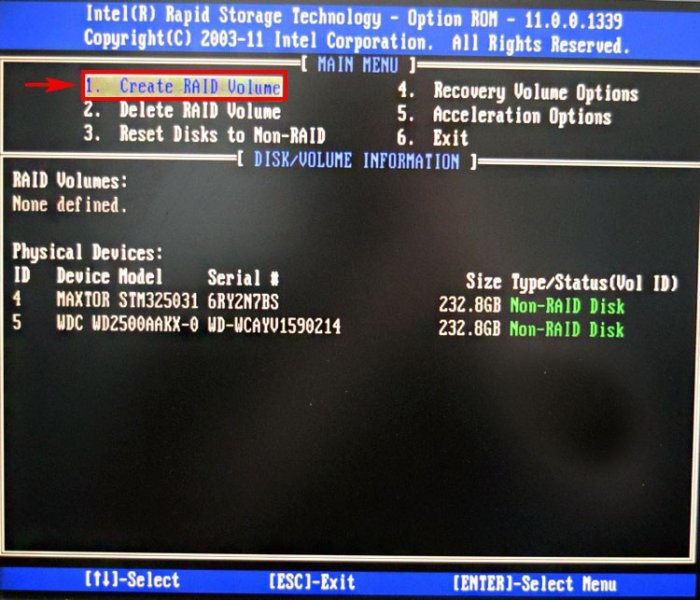

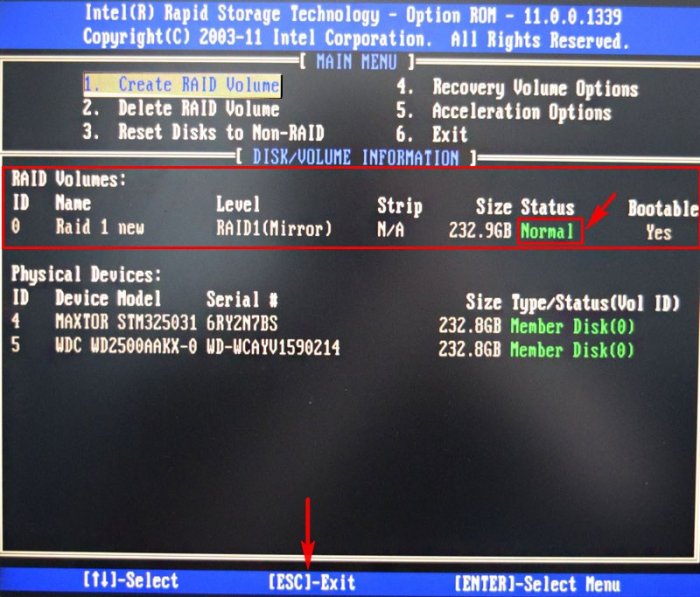

Также видно два подключенных к портам 4 и 5 жёстких диска SATA: Maxtor и WD, находящихся пока не в RAID-массиве ( Non-RAID Disk ). Нажимаем CTRL-I.

В начальном окне настроек выбираем с помощью стрелок на клавиатуре Create a RAID Volume (Создать том RAID) и жмём Enter.

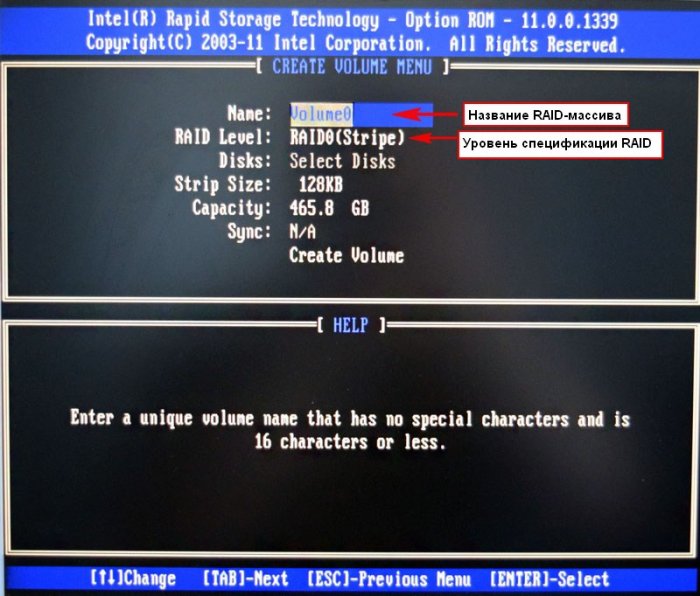

В данном окне производим основные настройки RAID-массива.

Name (название RAID-массива). Жмём на клавишу "пробел" и вводим наименование,

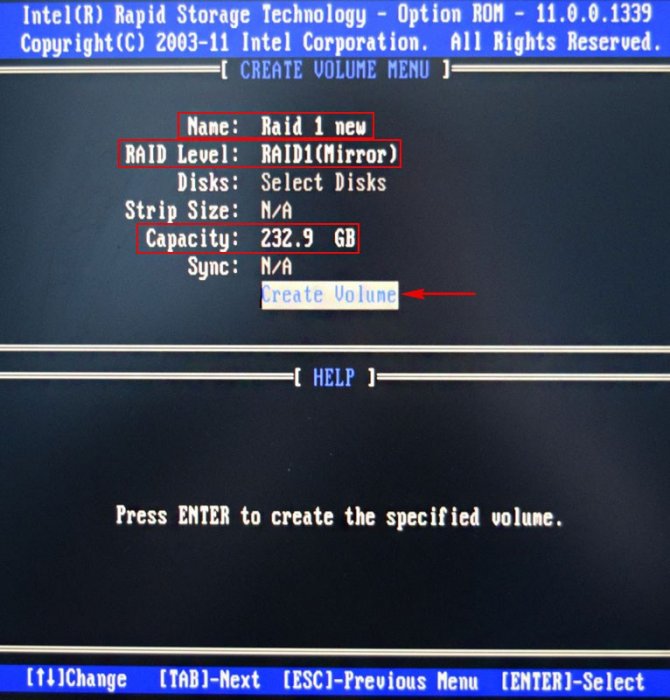

например " RAID 1 new" и жмём Enter. Передвигаемся ниже с помощью клавиши Tab.

RAID Level: (Уровень RAID). Мы будем создавать RAID1(Mirror) -"зеркалирование" - при отказе одного из дисков, точная копия данных останется на другом диске и контроллер сразу переключиться на использование дублирующего диска. Выбираем этот уровень с помощью стрелок на клавиатуре.

Capacity (объём) выставляется автоматически. Объём двух наших дисков 500 ГБ превращаются в 250 ГБ, так как мы используем уровень RAID1(Mirror) и два наших винчестера работают как один.

Больше ничего не меняем и передвигаемся к последнему пункту Create Volume и жмём Enter.

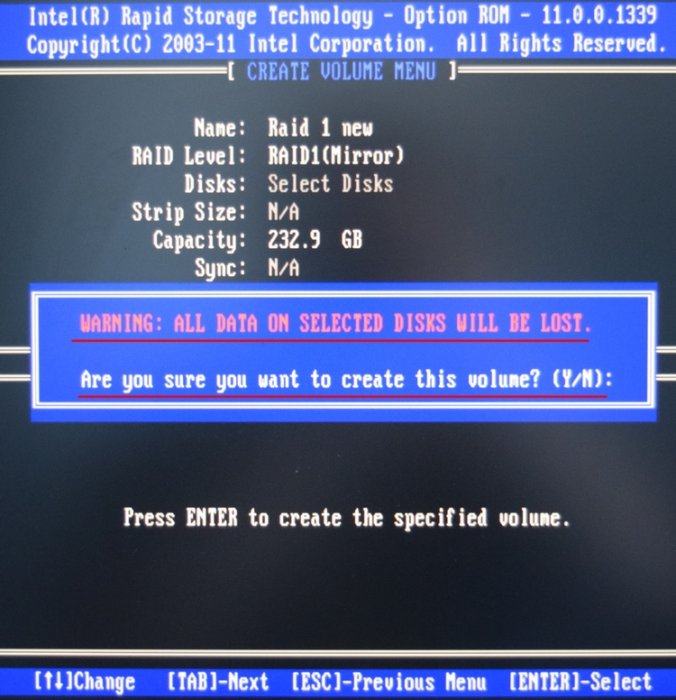

WARNING: ALL DATA ON SELECTED DISKS WILL BE LOST.

Are you sure you want to create this volume? (Y/N):

ВНИМАНИЕ: ВСЕ ДАННЫЕ на выбранных дисках будут потеряны.

Вы уверены, что хотите создать этот объем ? (Y / N):

Жмём Y (Да) на клавиатуре.

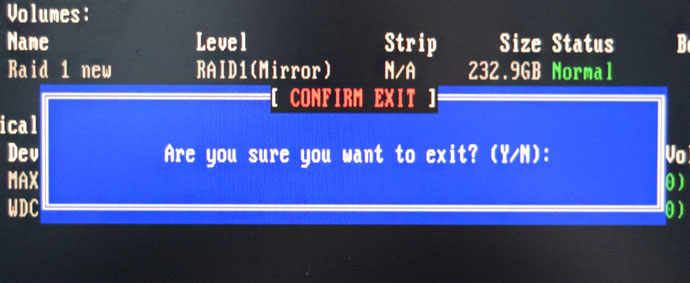

RAID 1 создан и находится со статусом Normal (нормальный). Для выхода жмём на клавиатуре клавишу Esc

Are you sure you want to exit (Вы уверены что хотите выйти? Нажимаем Y (Да).

Как видим, только что созданный нами RAID 1 массив с названием " RAID 1 new" тоже находится в загрузочном меню.

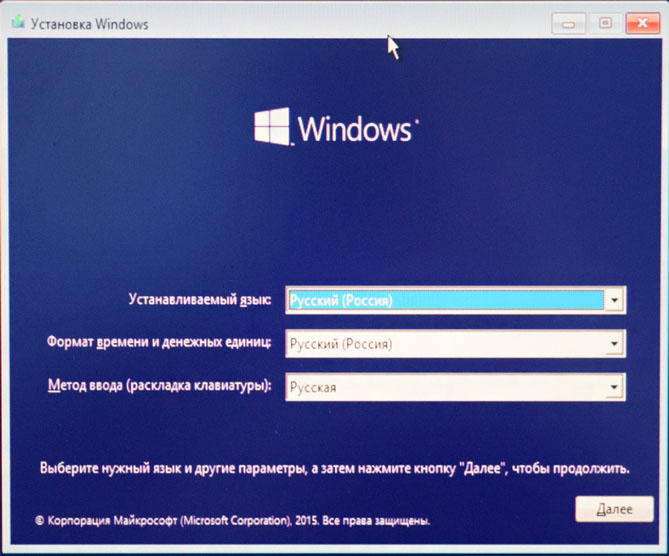

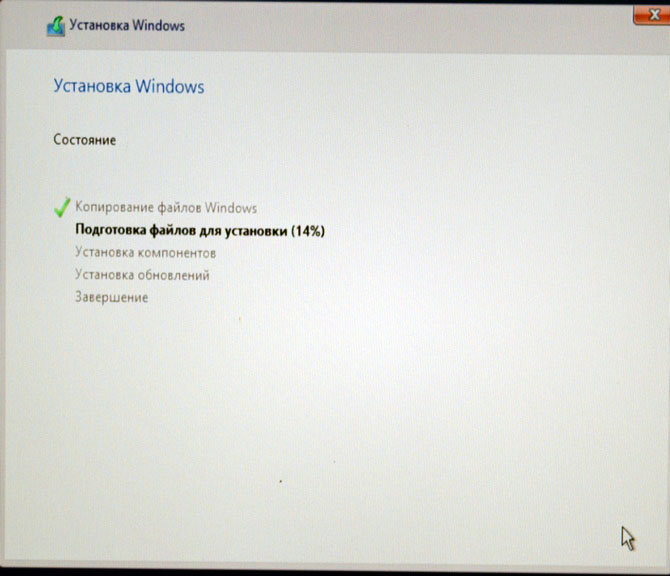

Загружаемся с флешки в программу установки Windows 10. Далее действуем как при обычной установке операционной системы.

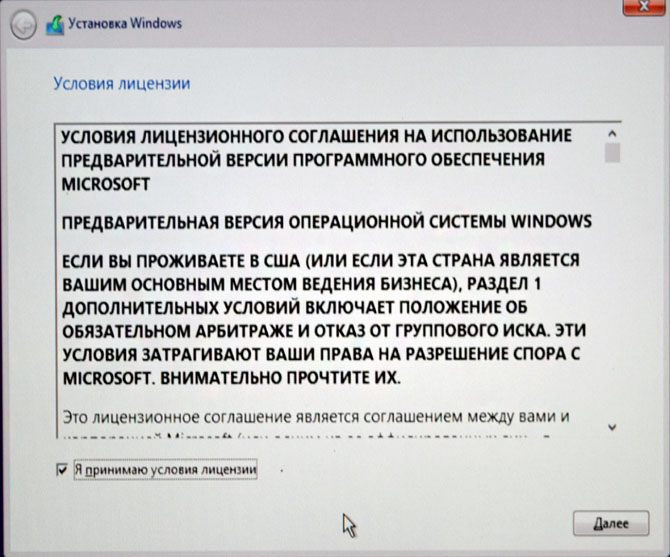

Принимаем лицензионное соглашение

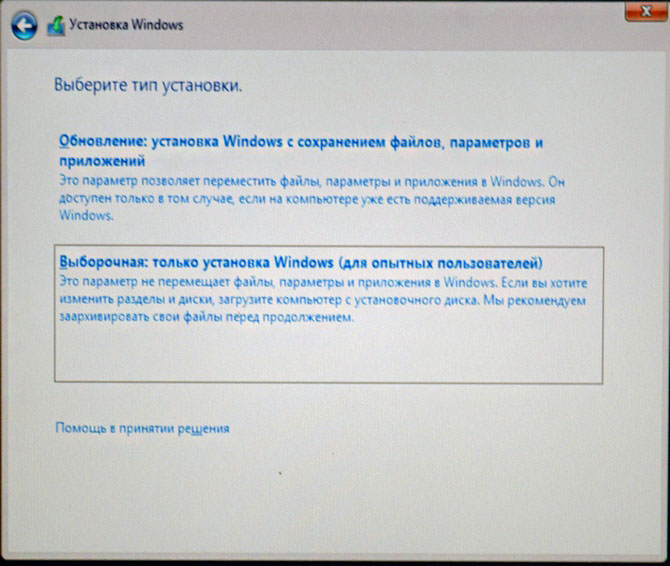

Выборочная: Только установка Windows

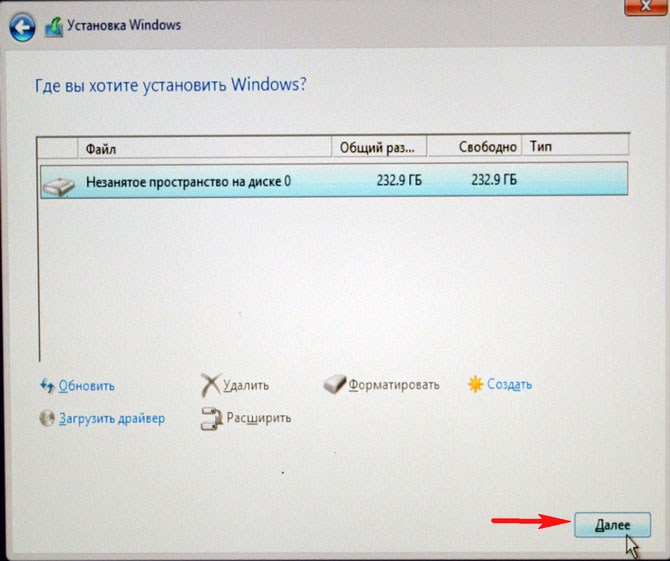

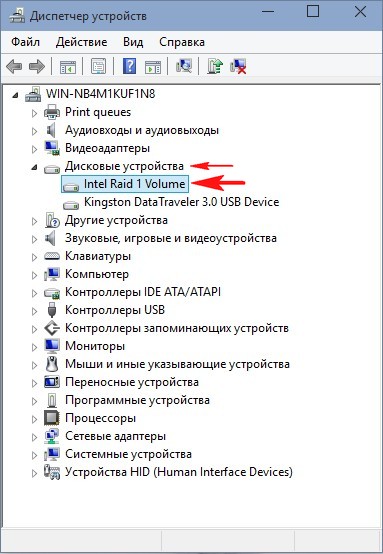

Два жёстких диска объединённых в RAID-массив установщик Win 10 видит как один.

Если хотите, можете создать разделы. Далее

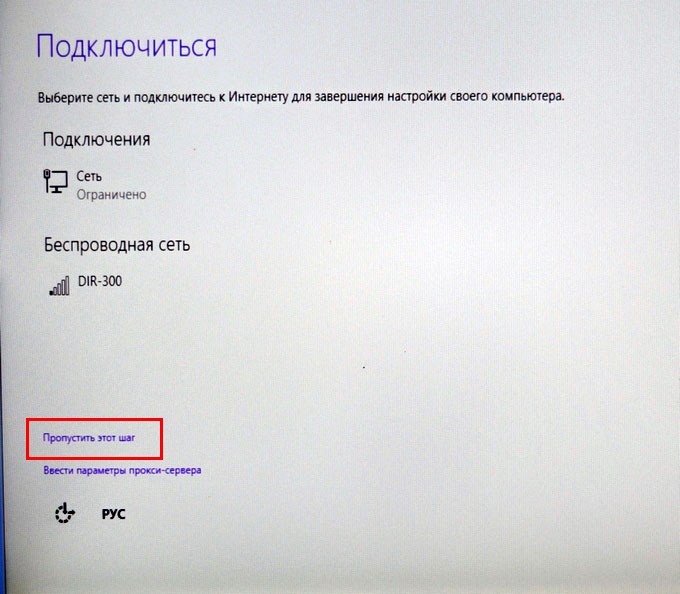

Пропустить этот шаг

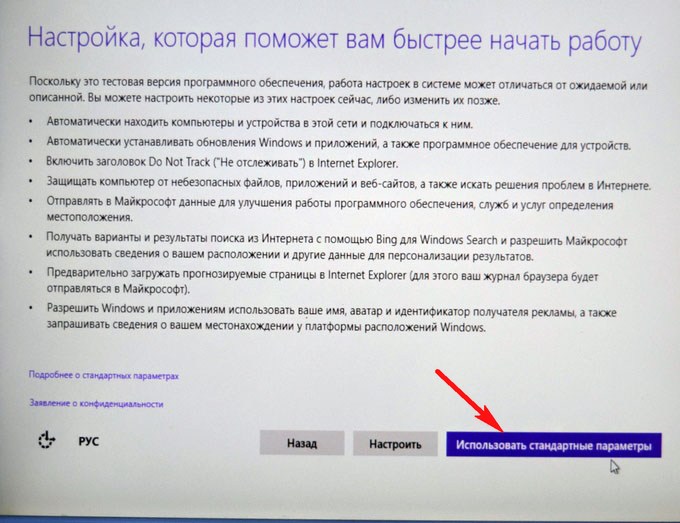

Использовать стандартные параметры

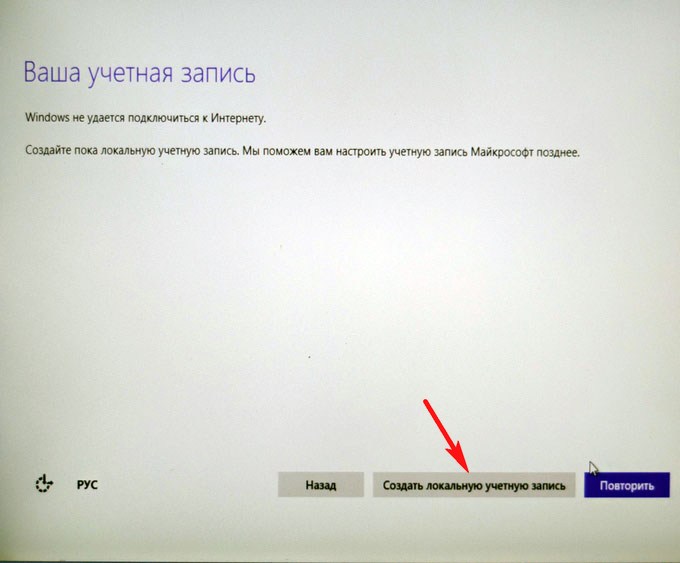

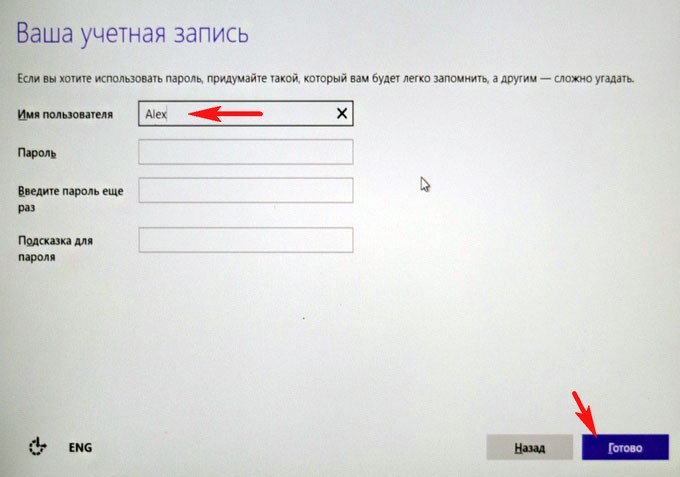

Создать локальную учётную запись

Вводим имя учётной записи и жмём Готово.

Windows 10 установлена на RAID 1 массив.

RAID 1 массив и флешка с Windows 10.

Друзья, если один жёсткий диск в независимом массиве вышел из строя, то операционная система загрузится со второго исправного винчестера, то есть с вашими данными ничего не случится, а вот как воссоздать RAID - массив, об этом поговорим в следующей статье.

Создали том RAID (виртуальный диск) в утилите предварительной загрузки, но по-прежнему не можете увидеть том RAID во время установки ОС Windows.

Выполните следующие действия для загрузки драйвера контроллера Intel RAID во время установки ОС Windows (в Intel® VROC примере):

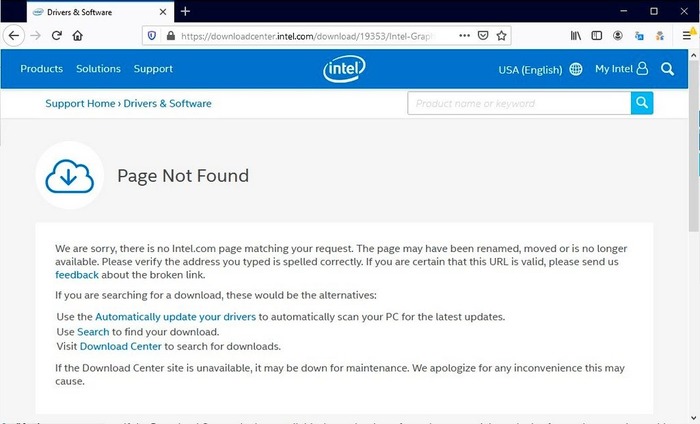

- Загрузитедрайвер Windows для своего Intel RAID Controller и сохраните его на USB-диске.

- НажмитеЗагрузка драйвера на экране Где вы хотите установить ОС Windows?

- НажмитеПросмотреть И Перейдите к местоположению драйвера RAID, загруженного в шаге 1, затем НажмитеХорошо.

Другие статьи по этой теме

Вам нужна дополнительная помощь?

Оставьте отзыв

Отказ от ответственности

Содержание данной страницы представляет собой сочетание выполненного человеком и компьютерного перевода оригинального содержания на английском языке. Данная информация предоставляется для вашего удобства и в ознакомительных целях и не должна расцениваться как исключительная, либо безошибочная. При обнаружении каких-либо противоречий между версией данной страницы на английском языке и переводом, версия на английском языке будет иметь приоритет и контроль. Посмотреть английскую версию этой страницы.

Для работы технологий Intel может потребоваться специальное оборудование, ПО или активация услуг. // Ни один продукт или компонент не может обеспечить абсолютную защиту. // Ваши расходы и результаты могут отличаться. // Производительность зависит от вида использования, конфигурации и других факторов. // См. наши юридические уведомления и отказ от ответственности. // Корпорация Intel выступает за соблюдение прав человека и избегает причастности к их нарушению. См. Глобальные принципы защиты прав человека в корпорации Intel. Продукция и программное обеспечение Intel предназначены только для использования в приложениях, которые не приводят или не способствуют нарушению всемирно признанных прав человека.

На днях столкнулся с совсем неочевидной проблемой. Хотя что могло быть сложнее поставить Windows 2019 на новый сервер.

Материнская плата Supermicro X11DPL-i, биос обновлен до последней версии 3.3 на 20.11.2020.

Диски 2х SSDSC2KG48

Режим загрузки Legacy (UEFI глобально ничего бы не изменил).

Задача: собрать softraid на встроенном контроллере в чипсет и установить Windows Server 2019.

Почему не внешний контроллер: единственный доступный в 1U корпусе слот оказался занят сетевой картой, поэтому даже при желании его было не поставить. надо было ставить Linux и вообще ceph и все в шоколаде

Действие первое:

1.1 Подключаем 1 диск для проверки.

1.2 Включаем PCH SATA Configuration - Configure SATA as RAID , перезагружаемся.

1.2.1 Обращаю внимание, что на плате есть еще второй sSATA контроллер (Second SATA), который по умолчанию включен.

1.3 Ждем, где клацать Ctrl-I и не видим. Не загружается утилита конфигурации виртуального контроллера. После инициализации OpROM сетевых карт начинает грузиться с них же.

1.4 Возвращаемся в биос, проверяем, что все нормально, перезагружаемся - не работает.

1.5 Гуглим решение: оказывается нужно как минимум 2 диска, чтобы загрузилась.

1.6 Подключаем второй диск, все начинает работать.

Вот казалось бы, вроде логично, что массив собирается только из 2 и более дисков, но почему утилита грузится с теми же требованиями?

P.S. забегая наперед, если один из дисков умрет или его отключить и массив развалится, то утилита загрузится и покажет, что массив degraded, поэтому можно спать спокойно.

Действие второе:

2.1 Массив собрали, массив в boot menu появляется, вставляем флешку/грузим по сети/подключаем через IPMI (подчеркните сами нужное) с образом Windows Server 2019 (md5 B2626D444A641604F325B145AB0C86F1), включаем сервер

2.2 Загружается установщик, клацаем далее, встречаем пустое окно при выборе дисков.

В смысле, как так? Нету драйверов под стандартный intel raid? Такого быть не может.

2.3 ОК, лезем на сайт Supermicro к нашей модели материнки, скачиваем "Intel PCH Driver(SATA)", перепаковываем в ISO, подключаем через IPMI, пробуем скармливать . и не кушает.

2.4 ОКК, лезем на сайт Intel, ищем драйвер Intel SoftRaid/VROC, получаем пакет VROC_7.0.0.2291_F6.

2.5 Перепаковываем в iso, подключаем . и опять не работает. Да как так то?

2.6 Идем в биос, лазим по нему в поисках слов "raid", "intel vroc", "boot volume". В итоге понимаем, что нигде ничего нет, да и вообще, все должно работать. Лезем в Ctrl+I, у него все круто, проблем никаких, рейд собран, помечен как Bootable.

Бросаем это затею и идем гуглить.

"Supermicro X11 server 2019" "Intel VROC server 2019" "X11 softraid windows server installer"

Единственное похожее упоминание о проблеме есть тут в ветке комментариев:

Тут есть упоминание о sSATA, но к нему у нас не подключены диски, так что в итоге он был отключен вообще.

Итак, действие третье:

3.1 Вспоминаем, что у нас есть WinPE на базе Win10 (у меня это StrelecPE), пробуем загрузиться в него.

3.2 Открываем диспетчер устройств, обнаруживаем кучу неопознанных устройств, как обычно, но среди которых нету RAID-контроллера.

3.3 Значит драйвер для него установлен. да, так и есть драйвер "Intel Embedded Server RAID Technology II" установлен, успешно запустился и работает. Но в оснастке управления дисков (он же diskpart) массива так и нет.

3.3.1 ID устройства PCI\VEN_8086&DEV_2826&CC_0104

3.4 ОК, подключаем еще раз новые драйвера с сайта Intel, пытаемся скормить драйвер и вуаля, шайтан машина таки жива, диск мгновенно появляется. (Момент скрина был позже событий, поэтому система уже установлена. Изначально диск конечно же был пустой)

3.3.1 На этом моменте все умные уже предполагают, о чем будет следующее действие.

3.5 Монтируем ISO с установщиком ОС, запускаем setup.exe, диск успешно видится, система начала копировать файлы.

3.5.1 Да, можно было распаковать и через другие утилиты установки из-под WinPE, можно было через cmd распаковать сразу на диск, потом доделать загрузчик, но зачем? Если можно просто нажать далее и он сделает все сам.

3.6 setup.exe радостно сообщает, что файлы все скопировал и надо перезагрузиться.

Вроде все? Но нет.

После перезагрузки сразу получаем BSOD Inaccessible Boot Device, который как бы намекает.

Не то чтобы намекает, он напрямую говорит, что загрузчик запустил ядро, но ядро не нашло загрузочного диска. А почему?

Потому что в образе системы предустановлен тот самый драйвер, который загружается без ошибок для данного устройства, но по факту не работает.

Действие четвертое, заключительное:

4.1 Грузим опять WinPE.

4.2 Устанавливаем рабочий драйвер в WinPE.

4.3 Открываем Dism++, открываем сессию на установленную систему на дисках, импортируем туда рабочий драйвер

4.4 Перезагружаемся. Вуаля, система продолжает ставится без каких-либо проблем.

Это можно было бы сделать сразу в действии третьем (3.3.1), но так как setup.exe не предлагает не перезагружаться, в моем случае это было недоступно, да и я сам хотел проверить, заработает оно или нет без этого.

Что произошло:

Как я предполагаю, в Intel что-то поменяли в прошивке виртуального raid-контроллера (версия Sata Option ROM 6.2.0.1034), оставив старый DeviceID. Скорее всего хотели не сломать совместимость с уже интегрированными драйверами в образах Windows Server 2012R2, 2016 и 2019. Установочные образы 2012R2, 2016 ведут себя аналогично 2019. Так и получилось, драйвер ставится, загружается, но где-то что-то идет не так и он не работает.

Я склоняюсь к этой версии, так как точно помню, что в основном Windows без проблем встают на Intel SoftRaid, без дополнительных драйверов.

В любом случае, драйвер был загружен, но диски в систему не передавал, а результатом стала вроде и простая, но неочевидная ситуация, которую разрулить стандартными средствами невозможно. Установщик отказывается ставить драйвер для контроллера дисков, если у него уже есть драйвера, даже если нерабочие.

Так как эта платформа была в единственном экземпляре, то такой порядок действии вполне нормальный, но если таких было бы несколько, то хорошим решением было бы пересобрать дистрибутив с интегрированными рабочими драйверами. Насколько такое решение является "стандартным средством" решать вам.

Лига Сисадминов

658 постов 12.3K подписчика

Правила сообщества

В последнее время ставлю или VMware Esx или proxmox - а винду уже тудаСупермикро, как бы это сказать, не очень)). 6 (!) раз переустанавливали сервер 2012рэ2 (да, давно было), он стабильно бсодил при загрузке с непонятной дженерал еррор, хотя ставился на рэйд только так. Бубен не помогал. Махнули местами процы - поехал сука.

Один вопрос: а чем софтовый рейд не угодил ?

У меня уже 6 лет моторесурса дисков в зеркале, рейд пережил три-четыре раз переустановку винды, при чём начиная с 8.1 на нынешнюю 10.

Зачем тебе рэйд-режим работы контроллера если рэйд нужен софтовый?

Вообще не понятно зачем все это. Собрал этих платформ чертову тучу. Драйвера подбрасываются прямо из инсталятора.

1. Качаешь драйвера с сайта Супермикро - по моему называются Intel SATA или Intel PCH

2. Названия не очевидные какой подкидывать. Перваый раз просто выбирал сверху вниз, заняло около получаса попробовать перебором. И на этом все. проблем нет.

3. Если собрал рейд на sSATA - то в драйверах с сайта Супермикро где-то рядом фалик.

4. Конечно HPE или DELL будут проще настраиваться, да и с гарантией получше "чуток", Но при этом деньги совсем другие, особенно если массив большой.

Нафиг эти все танцы - драйвера в ISO встраивать. Хотя это круто, что автор умеет это делать.

Слил исошку с дровами с оф сайта супермикро, распаковал, и в процеесе установки винды с диска (через usb dvd), просто подкинул дрова и все установилось без проблем на софт рейд 101. можешь прислать ссылку на прямо вот точные драйвера которые тебе в итоге подошли

2. с Dism++ не понял, загрузился в режиме PE, запустил DISM, нашлась установленная система 2016, примонтировал, открыл сессию, добавил драйвера, закрыл сессию, перезагрузился - проблема осталась. Как правильно в Dism++ эту операцию делать?

Здравствуйте, подскажите вот такую вещь, подогнали материнку X11SSH-F, как у нее попасть в BIOS?

Чёт я малость запутался - ты в середине пишешь, что интегрировал драйвера в исо, но это не помогло. А в конце пишешь, что надо бы по хорошему интегрировать драйвера в инсталлятор и тогда всё должно быть ништяк. В чём отличие?

И дополнение - на работе есть два сервера с матерями супермикро, год назад решал на одной из них проблему, хоть убей, не помню уже какую, но которая вылезла на ровном месте и какой на любой другой матери не было и быть не должно. Так толком и не решил, обошёл. И с тех пор я к ним ниочинь.

Если уж использовать программный рейд, то какой смысл это делать на intel, а не средствами ОС?

Заморочился нашёл способ поставить ОСЬ:

1. ISO Стрельца с WINPE

5 лет как свалил с on-premise, а костыли там всё те же.

На сервере использовать SSD 3D NAND TLC ? Серьёзно?оо

А raid не зеркало из них случаем? Ну чтобы умирали одновременно.

твоя ошибка в первой же строчке раздела Дано.

не надо брать эту хуергу, супермайкро ебучее.

ни разу не было таких проблем с серверами крупных брендов.

Windows спустя месяц

Лучше не приходи.

Вроде хорошее предложение, но как-то сомнительно.

Даже если и недалеко, не приходи.

А с другой стороны, этой фотографии как минимум лет 10, и кто знает,может бывший эникейщик сейчас развертывает на предприятиях RedHat и ставит домохозяйкам Gentoo?

Раритет

Сегодня полез смотреть проверять доступность Windows 10 October 2020 Update в параметрах системы. Действительно, появилось в необязательных, но речь уже не об этом, так как заметил, что для обновления доступны ещё два драйвера.

Последний меня заинтересовал и я полез в диспетчер устройств смотреть дату выпуска текущего драйвера со схожими признаками (PCIe, 1901), а там.

Оказалось, что у меня на компе один из первый драйверов, написанных Intel аж в день своего основания.

Такой раритет я, пожалуй, оставлю без обновления. ))

Пожелание сотрудницы

Видимо очень хорошая сотрудница

Intel «похоронит» базу данных драйверов для старых ПК

В эту пятницу, 22 ноября, Intel удалит со своих серверов все драйверы и BIOS для чипсетов, процессоров, видеокарт и других устройств, которые были выпущены более десяти лет назад. Сейчас при попытке загрузки такого ПО в верхней части страницы появляется соответствующее предупреждение. Дополнительно компания избавится от подобных файлов, предназначенных для работы под управлением операционных систем Windows 98, ME, XP и Windows Server, которые больше не поддерживаются Microsoft.

Владельцы устаревшего оборудования по-прежнему смогут загружать необходимые драйверы из сторонних источников, но делать это им придётся на свой страх и риск.

Разработчики Linux и Windows работают над закрытием огромной уязвимости в процессорах

Фундаментальная ошибка проектирования всех современных процессоров Intel, выпущенных за последние 10 лет, заставила разработчиков Linux и Windows в срочном порядке переписывать значительные куски кода ядер для того, чтобы закрыть недавно открытую в них уязвимость. Архитектура ARM64 также подвержена уязвимости.

Детали уязвимости находятся под эмбарго до тех пор, пока не будут выпущены исправления, которое намечается на середину января 2018 года, когда выйдет новое ядро Linux и ежемесячное обновление безопасности для Windows. Проблема возможно уже исправлена в ядре 4.14.11, учитывая огромный размер инкрементного патча (229 KiB).

По известным сейчас данным, обход этой аппаратной проблемы может привести к падению производительности приложений на процессорах Intel от 5 до 30% и даже до 63% на некоторых задачах. Более новые чипы от Intel имеют в своём арсенале возможности (PCID / ASID), позволяющие сократить провал в производительности при применении исправления.

Суть уязвимости, скорее всего, заключается в том, что процессоры Intel при спекулятивном выполнении кода не выполняют проверки на безопасность инструкций, которые позволяют читать сегменты памяти, что позволяет любому пользовательскому приложению получить доступ к памяти ядра, тем самым позволяя прочитать закрытые данные, такие как ключи шифрования и пароли. Большую опасность проблема также представляет для систем виртуализации, так как позволяет получить доступ к памяти вне гостевой системы.

Для решения проблемы разработчикам ядер пришлось полностью разделить память ядра и память пользовательских приложений, однако такое решение приводит к серьёзному падению производительности из-за постоянной необходимости замены указателей на память. Разработчики ядра Linux в шутку предлагали следующие аббревиатуры для новой модели разделения памяти ядра и пользовательских процессов: User Address Separation (*_uass) и Forcefully Unmap Complete Kernel With Interrupt Trampolines (fuckwit_*), однако остановились на Kernel Page Table Isolation (kpti_*).

Разработчики из GRSecurity протестировали патчи и увидели огромное падение производительности. Разработчики PostgreSQL отметили падение производительности в тесте pgbench на 23% (при использовании процессоров с PCID - 17%). Из-за сильного влияния на производительность разработчики патча предусмотрели опцию для отключения KPTI, которая активируется через передачу параметра "nopti" при загрузке ядра.

Компания AMD утверждает, что её процессоры уязвимости не подвержены. Работа над исправлением уязвимости в других операционных системах также активно ведётся

В этой статье мы рассмотрим, как создать программное зеркало (RAID1) из двух GPT дисков в Windows Server 2016/Windows 10, установленных на UEFI системе. Мы рассмотрим полноценную конфигурацию BCD загрузчика, позволяющую обеспечить корректную загрузку Windows и защитить данные от выхода из строя любого диска.

В подавляющем большинстве случаев при выборе между программным или аппаратным RAID стоит выбирать последний. Сейчас материнские платы со встроенным физическим RAID контроллером доступны даже для домашних пользователей.Запишите установочный образ Windows на DVD/ USB флешку, загрузите компьютер) с этого загрузочного устройства (в режиме UEFI, не Legacy) и запустите установку Windows Server 2016.

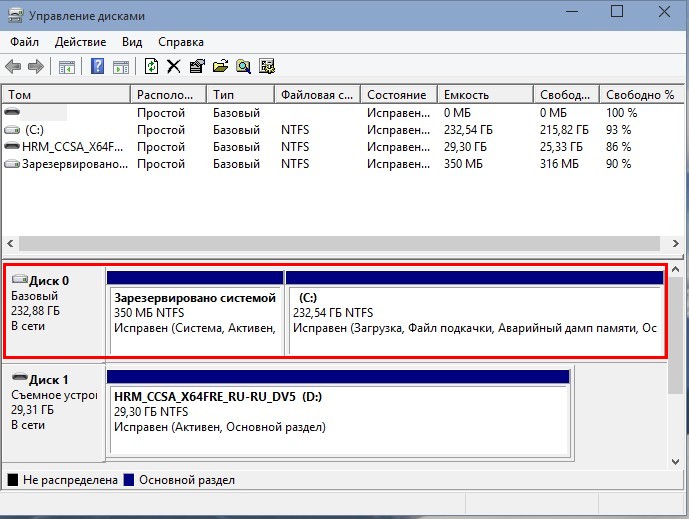

После установки, откройте консоли управления дисками (diskmgmt.msc), убедитесь, что на первом диске используется таблица разделов GPT (свойства диска -> вкладка Volumes -> Partition style –> GUID partition table), а второй диск пустой (неразмечен).

Подготовка таблицы разделов для зеркала на 2 диске

Откройте командную строку с правами администратора и выполните команду diskpart. Наберите:

Как вы видите, в системе имеется два диска:

- Disk 0 – диск с таблицей разделов GPT, на который установлена Windows

- Disk 1 – пустой неразмеченный диск

На всякий случай еще раз очистим второй диск и конвертируем его в GPT:

Введите список разделов на втором диске:

Если найдется хотя бы один раздел (в моем примере это Partition 1 – Reserved – Size 128 Mb), удалите его:

Delete partition override

Выведите список разделов на 1 диске (disk 0). Далее вам нужно создать такие же разделы на Disk 1.

Имеется 4 раздела:

- Recovery – 450 Мб, раздел восстановления со средой WinRE

- System – 99 Мб, EFI раздел (подробнее про структуру разделов на GPT дисках)

- Reserved 16 Мб, MSR раздел

- Primary – 49 Гб, основной раздел с Windows

Создаем такие же разделы на Disk 1:

Create partition primary size=450

create partition efi size=99

create partition msr size=16

Преобразования дисков в динамические, создание зеркала

Теперь оба диска нужно преобразовать в динамические:

Создадим зеркало для системного диска (диск C:). Нужно выбрать раздел на первом диске и создать для него зеркало на 2 диске:

Select volume c

Add disk=1

Откройте консоль управления дисками, и убедитесь, что запустилась синхронизуя раздела C на (Recynching). Дождитесь ее окончания (может занять до нескольких часов в значимости от размера раздела C: ).

При загрузке Windows теперь будет появляться меню Windows Boot Manager с предложение выбрать с какого диска загружаться. Если не выбрать диск вручную, система через 30 секунд попытается загрузиться с первого диска:

- Windows Server 2016

- Windows Server 2016 – secondary plex

Однако проблема в том, что сейчас у вас конфигурация загрузчика хранится только на 1 диске, и при его потере, вы не сможете загрузить ОС со второго без дополнительных действий. По сути вы защитили данные ( но не загрузчик Windows) только от сбоя второго диска.

Программный RAID Windows не получится использовать для создания нормального зеркала EFI раздела. Т.к. на EFI разделе хранятся файлы, необходимые для загрузки ОС, то при выходе их строя первого диска, вы не сможете загрузить компьютер со второго диска без ручного восстановления загрузчика EFI на нем в среде восстановления. Эти операции довольно сложно сделать неподготовленному администратору, а также потребует дополнительного времени (которого может не быть, если у вас за спиной стоит толпа разгневанных пользователей).

Далее мы покажем, как скопировать EFI раздел на второй диск и изменить конфигурацию загрузчика BCD, чтобы вы могли загрузить Windows как с первого, так и со второго диска.

Подготовка EFI раздела на втором диске в зеркале

Теперь нужно подготовить EFI раздел на втором диске в зеркале, чтобы компьютер мог использовать этот раздел для загрузки Windows. Назначим EFI разделу на Disk 1 букву S и отформатируем его в файловой системе FAT32:

format fs=FAT32 quick

Теперь назначим букву диска P: для EFI раздела на Disk 0:

select partition 2

Копирование конфигурации EFI и BCD на второй диск

Выведите текущую конфигурацию загрузчика BCD с помощью команды:

При создании зеркала, служба VDS автоматически добавила в конфигурацию BCD запись для второго зеркального диска (с меткой Windows Server 2016 – secondary plex).

Чтобы EFI в случае потери первого диска могут загружаться со второго диска, нужно изменить конфигурацию BCD.

Для этого нужно скопировать текущую конфигурацию Windows Boot Manager

bcdedit /copy /d "Windows Boot Manager Cloned"

Теперь скопируйте полученный ID конфигурации и используйте его в следующей команде:

Если все правильно, должна появится строка The operation completed successfully.

Выведите текущую конфигурацию Windows Boot Manager (bcdedit /enum). Обратите внимает, что у загрузчика теперь два варианта загрузки EFI с разных дисков (default и resume object).

Теперь нужно сделать копию BCD хранилища на разделе EFI первого диска и скопировать файлы на второй диск:

P:

bcdedit /export P:\EFI\Microsoft\Boot\BCD2

robocopy p:\ s:\ /e /r:0

Осталось переименовать BCD хранилище на втором диске:

Rename s:\EFI\Microsoft\Boot\BCD2 BCD

И удалить копию на Disk 0:

В этом случае вы должны заменить неисправный диск, удалить конфигурацию зеркала и пересоздать программный RAID с начала.

В распакованном каталоге присутствует инструкция, как добавить драйвер в образ посредством которого когда снова установим ESXi на флешку, гипервизор посредством имеющихся драйверов на установленный в систему RAID контроллер сможет работать с дисками:

- RAID 1 = 2 по 500Gb

- RAID 1 = 2 по 2Tb

Теперь загружаю виртуальную машину Virtualbox с осью Windows 7 на борту и подготавливаю рабочее окружение для сборки с учетом скачанных драйверов на RAID контроллер:

Для сборки своего образа ESXi потребуется:

Разрешаю запуск PowerShell скриптов:

Пуск — Все программы — Стандартные — Командная строка и через правый клик на ней запускаем «Запуск от имени администратора»

C:\Windows\system32>cd /d C:\Windows\System32\WindowsPowerShell\v1.0

C:\Windows\system32>powershell

PS C:\Windows\System32\WindowsPowerShell\v1.0>set-executionpolicy remotesigned

Устанавливаю в систему пакет: PowerShell 3.0 (Windows6.1-KB2506143-x86), без предыдущего не будет и этого.

Устанавливаю в систему пакет: VMware-PowerCLI-6.0.0-3056836.exe

Устанавливаю в систему пакет: 7zip

На данной рабочей станции потребуется доступ в интернет

- Через общие папки передаю с основной системы на гостевую скачанный файл драйвера и найденный на просторах интернета скрипт: ESXi-Customizer-PS-v2.4.ps1

- md5sum ESXi-Customizer-PS-v2.4.ps1 5af8f83ec08faaed500294b69b920d0a ESXi-Customizer-PS-v2.4.ps1

Пуск — Все программы — Vmware — Vmware vSphere PowerCLI и через правый клик «Запуск от имени администратора»

Создаю папку Driver и помещаю в нее vib файл

PowerCLI C:\> mkdir C:\Drivers

В данную папку помещаю файл драйвера для моего RAID контроллера :

vmware-esxi-drivers-scsi-aacraid-550.5.2.1.40301.-1.5.5.1331820.x86_64.vib

PowerCLI C:\> .\ESXi-Customizer-PS-v2.4.ps1 -obDir .\Drivers -sip -v55

Parameter name: value.Width

+ CategoryInfo : NotSpecified: (:) [], SetValueInvocationException

Script to build a customized ESXi installation ISO or Offline bundle using the VMware PowerCLI ImageBuilder snapin

(Call with -help for instructions)

Running with PowerShell version 3.0 and VMware vSphere PowerCLI 6.0 Release 2 build 3056836

Select Base Imageprofile:

Enter selection: 1

(dated 11/18/2015 20:26:01, AcceptanceLevel: PartnerSupported,

После того, как создастся образ (в моем случае он именуется , как: ESXi-5.5.0-20151204001-standard.iso) копирую его также через «Общие папки» в основную систему Ubuntu 12.04.5 Desktop amd64 и по аналогии как делал по заметке делаю загрузочную флешку.

$ sudo parted /dev/sdb

(parted) mklabel gpt

Предупреждение: Существующая метка диска на /dev/sdb будет уничтожена и все

данные на этом диске будут утеряны. Вы хотите продолжить?

Да/Yes/Нет/No? Yes

(parted) unit GB

(parted) mkpart primary 0.00Gb 4.00Gb

(parted) print

Модель: JetFlash Transcend 4GB (scsi)

Диск /dev/sdb: 3911MB

Размер сектора (логич./физич.): 512B/512B

Таблица разделов: gpt

Номер Начало Конец Размер Файловая система Имя Флаги

1 1049kB 3910MB 3909MB fat16 primary

(parted) quit

Информация: Не забудьте обновить /etc/fstab.

$ sudo mkfs.msdos /dev/sdb1

mkfs.msdos 3.0.12 (29 Oct 2011)

$ sudo mkdir /media/cdrom

$ sudo mount /dev/sdb1 /media/cdrom

$ /usr/bin/unetbootin method=diskimage isofile="/home/aollo/ISO/ESXi-5.5.0-20151204001-standard_Adaptec_6805E.iso" installtype=USB targetdrive=/dev/sdb1 autoinstall=yes

$ sudo umount /dev/sdb1

или же просто без какой либо автоматизации:

Теперь подключаю данную флешку в сервер SuperMicro и произвожу установку гипервизора ESXi на неё же, но вот беда — не идет установка, только появляется надпись:

Mission operation system

Диск /dev/sdb: 3911 МБ, 3911188480 байт

39 головок, 38 секторов/треков, 5154 цилиндров, всего 7639040 секторов

Units = секторы of 1 * 512 = 512 bytes

Размер сектора (логического/физического): 512 байт / 512 байт

I/O size (minimum/optimal): 512 bytes / 512 bytes

Идентификатор диска: 0xf77e43f8

Устр-во Загр Начало Конец Блоки Id Система

/dev/sdb1 1432 7639039 3818804 b W95 FAT32

$ sudo mount /dev/sdb1 /media/cdrom

образ успешно записался и подключив флешку к серверу произвожу установку, но опять результат тот же гипервизор не обнаруживает драйверов на RAID контроллер.

/adaptec/vsphere_esxi_5.5$ mv vmware-esxi-drivers-scsi-aacraid-550.5.2.1.40301.-1.5.5.1331820.x86_64.vib adaptec.vib

/adaptec/vsphere_esxi_5.5$ scp adaptec.vib [email protected]:/

adaptec.vdi 100% 61KB 60.6KB/s 00:00

Подключаюсь к серверу ESXi с помощью клиента SSH и устанавливаю драйвер, а затем для принятия изменений перезагружаю сервер

$ ssh -l root 10.7.8.153

The time and date of this login have been sent to the system logs.

VMware offers supported, powerful system administration tools. Please

The ESXi Shell can be disabled by an administrative user. See the

vSphere Security documentation for more information.

Message: The update completed successfully, but the system needs to be rebooted for the changes to be effective.

Reboot Required: true

VIBs Installed: Adaptec_Inc_bootbank_scsi-aacraid_5.5.5.2.1.40301-1OEM.550.0.0.1331820

VIBs Removed: VMware_bootbank_scsi-aacraid_1.1.5.1-9vmw.550.0.0.1331820

Connection to 10.7.8.153 closed.

После того, как сервер перезагрузится подключаюсь к нему с рабочей станции под управлением Windows 7 посредством клиент vSphere Client, проверяю наличие RAID контроллера и он присутствует:

ESXi (10.7.8.153) — Configure — Storage Adapters

Отлично гипервизор видит RAID контроллер, но вот теперь моя задача сводится к форматированию устройств, т. е. Я хочу переделать текущее (уже больше не нужно).

Configuration — Storage — выделяю хранилище, в моем случае оно именуется, как Data и нажимаю в правом углу на Delete, затем подтверждаю свое намерение

Но меня поджидает облом — видители гипервизор использует данные хранилища и удалить не дает:

*** The fdisk command is deprecated: fdisk does not handle GPT partitions. Please use partedUtil

Disk /dev/disks/mpx.vmhba32:C0:T0:L0: 7639040 sectors, 7460K

Disk /dev/disks/mpx.vmhba2:C0:T1:L0: 3900682240 sectors, 3719M

Disk /dev/disks/mpx.vmhba2:C0:T0:L0: 975155200 sectors, 929M

mpx.vmhba2:C0:T0:L0:1 /vmfs/devices/disks/mpx.vmhba2:C0:T0:L0:1 51fa6d03-0a61ea94-5b19-6805ca0a091f 0 System

Хранилище System я отключил

А вот отключить хранилище Data почему-то не могу:

watchdog-storageRM: Terminating watchdog process with PID 34001

ESXi-хост (10.7.8.153) — Configuration — Storage — нажимаю Rescan All

Не помогло, а вот еще проверяя расширенные параметры ESXi хоста наткнулся на вот такой вот параметр и

По найденному описанию на официальном сайте данное значение нужно изменить на /tmp сохранить внесенные изменения и перезагрузить хост

Connection to 10.7.8.153 closed.

После проверяю значение измененного параметра:

ничего не поменялось.

Пробую поменять через консоль:

Затем перевожу хост в режим обслуживания:

vSphere Client — ESXi-(хост) — через правый клик по хосту нахожу параметр Enter Maintenance Mode, подтверждаю свое намерение нажатием кнопки Yes

Connection to 10.7.8.153 closed.

После уже снова подключаюсь через vSphere Client и что самое главное успешно на всех хранилищах, таких как Data & System делаю umount и удаляю.

И только потом можно будет через vSphere Client удалить хранилища имеющее место быть в ранее созданном и используемое на предыдущей версии гипервизора ESXi текущего сервера.. Почему переделываю, дело в том, что той флешки на которой был установлен гипервизор уже много и много лет, да и сервак стал больше не нужным, а разобрать все в шагах по установке надо на всякий случай будет полезно.

Теперь заново создаю хранилища:

На этом моя заметка завершена. Я разобрал как создать свой образ, если не получилось как импортировать модуль в существующий гипервизор и как пересоздать локальные хранилища в основе которых лежат диски на Raid контроллере. До новых встреч, с уважением автор блога — ekzorchik.

Читайте также: