Ubuntu maas что это

Self-service, remote installation of Windows, CentOS, ESXi and Ubuntu on real servers turns your data centre into a bare metal cloud.

Welcome to metal-as-a-service.

Data centre automation

Your next rack is a bare metal cloud.

Metal-As-A-Service (MAAS) provisioning with Windows, ESXi, Linux.

Deploy any OS image

on any hardware

MAAS delivers the fastest OS installation times in the industry thanks to its optimised image-based installer.

You can deploy:

- Works on all Canonical certified servers

- Discovers servers in racks, chassis and data centre networks

- Supports major system BMCs and chassis controllers

Key features

Automation ›

Speed ›

Zero-touch deployment of Ubuntu, CentOS, Windows and RHEL. Full deployment time is approximately two boot cycles plus two minutes for disk imaging.

Inventory ›

Discover every PCI and USB device in every server. Inventory disk models and serial numbers. Provision machines based on specific configuration details to optimize your applications.

Storage layouts ›

IPAM, DHCP, DNS ›

Hardware testing ›

Run tests to get up to date information about hardware health. Benchmark disk, RAM, CPU and network performance.

DevOps on bare metal

Integration with Ansible, Chef, Puppet, SALT, and Juju. REST API, CLI and Python bindings enable full lifecycle and project automation.

Network monitoring ›

Continuously observes network traffic and catalogs every active IP address of unknown origin. Discovers rogue devices, IPs and MAC addresses. Drives active scanning of network ranges.

Authentication and Identity

Integrate with LDAP, Active Directory or SAML for central identity management and single-sign-on (SSO) across multiple MAAS regions.

Composable systems

Drive Cisco UCS, Intel RSD, HP Moonshot, and more. Supports dynamic hardware composition with Intel RSD.

Cloud metadata

Reuse standard cloud operations with cloud-init and metadata services. Hybrid multi-cloud operations now include bare metal, with no change in applications.

KVM micro-cloud

Designate servers to host KVM virtual machines to be dynamically provisioned alongside physical servers.

A selection of customers

Real servers,

self-service

You run the data centre, but your end users decide what they want to do with the hardware. They love the cloud experience, but it’s more efficient for you to own the hardware.

MAAS provides super-fast self-service provisioning of Windows, Ubuntu, CentOS and ESXi.

Bare-metal,

cloud experience

MAAS implements all the standard features of a public cloud — like instance metadata and cloud-init. Your customers get complete control of the deployed machine.

Canonical created cloud-init and leads the project globally; we ensure that MAAS provides a first-class cloud experience for physical servers based on x86, ARM64, POWER and Z architectures.

Real-world MAAS

Flexibility

MAAS KVM for micro-clouds and edge computing

The importance of bare metal provisioning in edge computing

Ease of use

Small & medium business

MAAS — Fast and efficient virtualisation for small and medium enterprises

Scale

Large-scale automated hardware testing with MAAS

Storage

Inventory, testing and benchmarking

MAAS detects and inventories all the disks, in every server. You’ll have a single database of every model and serial number.

MAAS tests disks either non-destructively or destructively, with short or long write cycles, and learns about their performance.

RAID, LVM, Bcache, ZFS and more

Auto-tagging of SSD and rotary disk types makes it easy to know which disks to use for each application.

Your users configure the storage of any server they control: RAID, LVM, Bcache and ZFS. Configure boot, applications and backup disks exactly where you want them — and get the installed machine, a few minutes later.

Network

Detection and configuration

The most error-prone part of data centre operations is the network.

MAAS enables rapid convergence on a correct network configuration — for every server, in every rack. All NICs are detected and inventoried when a machine is enlisted in MAAS.

Discover the topology of the network — which NIC is plugged into which port on which switch. MAAS tests access to specific VLANs from each NIC.

Network bonds and VLANs can be configured too. Set all significant network operating properties through MAAS — and then validate that configuration with ephemeral machine booting and testing.

Monitoring

MAAS rack controllers provide local endpoints for all infrastructure services in the rack itself, and they also monitor the local network for rogue devices, IP addresses and MAC addresses.

Over time, you’ll know if there are ‘extra’ devices plugged into any fabric or VLAN that MAAS is asked to monitor.

Solve network mysteries faster with distributed network analysis and observation.

Learn how to configure and install MAAS

Your future data centre, available now

Carrier-grade infrastructure DNS, DHCP, and IPAM

MAAS integrates best-of-breed ISC DHCP and Bind9 DNS, and will operate these in high availability mode whenever redundant MAAS services are provided. Deploy the MAAS API services on two systems and you will have high availability API endpoints; deploy two rack controllers and all rack services are automatically redundant. MAAS uses the PostgreSQL database which supports redundant and highly available scenarios.

Devops on bare metal is easy with dynamic server provisioning

Take devops to bare metal for apps like big data, kubernetes, analytics, machine learning, private cloud, OpenStack, PAAS and HPC. Specialists love MAAS.

Open source software-defined data centre

MAAS is an open source SDDC solution used by telcos, financial institutions, media companies and supercomputer admins to take care of all the low-level details. PXE, IPMI, ILO and all the custom protocols needed for diverse vendor hardware support come together in one clean REST API with Python bindings for easy integration and automation. It includes full IPAM capabilities, providing a central database and REST API for all network addressing and naming information.

KVM MicroCloud for Edge Computing

MAAS offers the ability to create lean, on-demand KVM-based micro-clouds. This capability extends to fine-grained control over KVM storage and networking configuration, thereby accelerating deployment of applications in any environment constrained by physical footprint or requiring dedicated VM-based workloads.

Сегодня я расскажу тебе, как при помощи напильника, кучки серверов и такой-то матери собрать что-то смутно похожее на EC2 от Amazon.

Статья получилась больше обзорная, так что придётся разбить её на несколько частей.

Я тебя слепила из того что было.

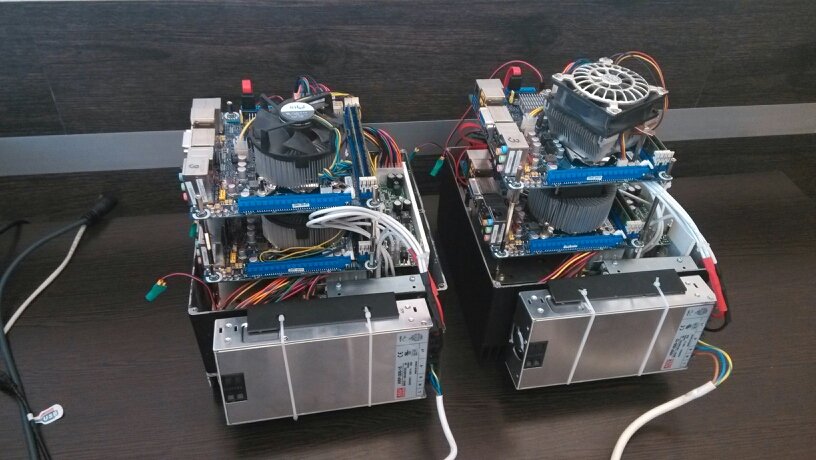

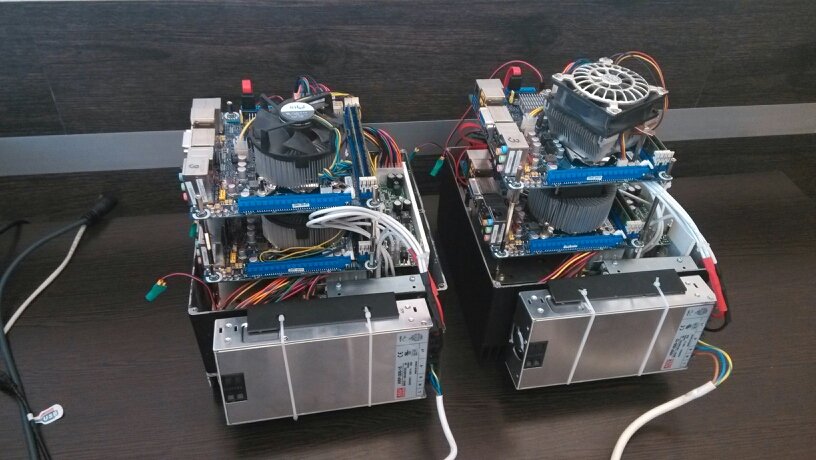

Это — демостенд, 6 х i5-3570T/8Gb RAM/рассыпуха всяких дисков.

Как-то встала у меня задача упорядочить все офисные сервисы, хаотично разбросанные по зоопарку серверов и операционок (у меня тут даже OpenBSD где-то бегает). И так вышло, что я давно хотел посмотреть на облака, а реального тесткейса не было. Так я и решил изучить, что нынче есть интересного в мире open-source и можно ли это применить в боевых условиях.

На текущий момент я посмотрел такие решения как MaaS + Juju имени Cannonical, RDO имени RedHat, Foreman с плагином и Fuel.

Забегая немного вперёд — Fuel для меня оказался самым адекватным, но пройдёмся по порядку.

MaaS

Простой и аскетичный дизайн

MaaS представляет собою концепцию Metal as a Service, по сути — занимается менеджментом «голого» железа. Вы можете выбрать какую версию убунты установить на тот или иной сервер, узнать его ТТХ и по сути всё. Сервера можно разделять по регионам доступности. Так же умеет работать с виртуалками через libvirtd. Интересное начинается когда вы прикручиваете ко всему этому Juju — теперь вы можете сказать «установи мне бложек» и оно выберет из списка доступного метала железку и накатит туда весь необходимый софт, как то mysql, apache, wordpress/drupal/etc. Мило, удобно, но когда я попытался подобным образом развернуть OpenStack, всё встало колом. Возможно я делал что-то не так, возможно что-то не так делали создатели конфигов для juju. Но в итоге мне не удалось нормально развернуть контроллер на одном сервере. Под каждый компонент контроллера оно хотело отдельную железку. Т.е. нужен вам keystone?, не вопрос — вот отдельный сервер под keystone. И так со всем. Ко всему этому добавилась моя нелюбовь к ubuntu как серверной ОС, так что решение пришлось отложить.

RDO

Foreman

Тысячи графиков, начальство будет счастливо

Сам по себе The Foreman это вебинтерфейс для управления puppet'овыми конфигами и в этой роли он вполне удобен и интересен. Но помимо этого он умеет и provisioning. Так что, как и с MaaS, вы можете сказать серверу грузиться по сети, а дальше управлять установкой через удобную вебморду. Имея такое удобное решение сложно было не прийти к идее разворачивания клауда на его основе. И всякие народные умельцы начали это потихоньку реализовывать. На текущий момент в nightly build'ах есть плагин foreman-installer-staypuft. С его помощью вы устанавливаете как сам Foreman, так и необходимые плагины. Удобство этой конструкции в том, что буквально из одной точки вы можете установить ОС (причём как Linux-based, так и Windows), после чего раздать нужные роли и установить необходимый набор софта. Или развернуть клауд, и опять же из вебморды foreman'а назначить роли для инстансов в этом клауде. Есть только одно существенное НО — ночные сборки достаточно нестабильны.

Возможно со временем это решение доделают и оно будет вполне production-ready, но на текущий момент можно только баловаться и отправлять багрепорты разработчикам. Благо они активно читают гугло-группу.

Fuel

У них похоже есть дизайнер

На текущий момент самое совершенное решение по разворачиванию клауда от достаточно именитой компании Mirantis. По сути — это заточенный исключительно на разворачивания клауда софт. Как и rdo/foreman — делает он это с помощью puppet'овых скриптов. Установка controller + 3 compute node занимает около 30 минут, зависит от скорости ваших винтов. Можно создавать как High availability, так и non-HA кластер. Умеет из коробки работать с Ceph, в версии 5.1 так же добавили драйвера для Mellanox'овых сетевух, что в комбинации LVM+Infiniband позволяет использовать RDMA (пока не проверял в действии, жду когда приедет свитч и сетевухи). Огромным плюсом является наличие большого количества документации.

В следующий раз я расскажу вам что же собственно у меня вышло сделать при помощи Fuel, немного про особенности ceph, как использовать несколько гипервизоров в одном клауде и как упростить себе жизнь автоматизировав всё и вся. А если ко мне таки доедет InfiniBand, то, возможно, и про особенности его работы с ceph и openstack.

Мы как-то уже писали о том, что такое PaaS, DBaaS, SaaS и другие *aaS. Все термины мы тогда не охватили, но это и не было целью. Есть еще один важный термин, который хотелось бы прояснить. Речь идет о MaaS (Monitoring-as-a-service).

Это важная услуга, которое с течением времени будет становиться только актуальнее. Она важна для большого количества компаний, которым необходимо следить за своим оборудованием и программным обеспечением постоянно. Возможно, и не в режиме 24/7, но достаточно часто. И тогда вот, что может произойти (мы с этим столкнулись, так что делимся наболевшим, так сказать).

Например, у вас есть сетевая инфраструктура, за работой которой нужно следить. Вы начинаете искать программу или сервис, которые помогут в осуществлении этой задачи, и находите их. Устанавливаете, и все начинает работать (сразу или после небольших танцев с бубном). Все хорошо.

Но есть еще и некий программный продукт, работу которого необходимо отслеживать. Повторяем предыдущие шаги, все хорошо. Потом становится необходимым отслеживать работу пользовательских устройств. Мы повторяем шаги, снова и снова.

Прежде, чем вы это осознаете, у вас получается целый букет программ или сервисов мониторинга, за которыми тоже нужно следить. Каждый сервис работает отлично, но все они не взаимодействуют друг с другом или же делают это на базовом уровне. Каждый сервис или программа потребляют ценные ресурсы. И это уже не букет, а целое поле цветов, за которыми должен следить ИТ-отдел, у которого, между прочим, есть и другие обязанности.

Сотрудникам этого отдела нужно платить деньги, и немалые. А с течением времени все эти сервисы мониторинга требуют все большего числа человеко-часов. Увеличиваются операционные затраты, работать становится все сложнее. И это еще ничего, но ведь может случиться и нечто худшее — взлом. ИТ-отдел, который должен предотвращать попытки взлома, просто тратил много времени и сил на мониторинг работы сервисов мониторинга (уж простите за тавтологию) и пропустил атаку.

Конечно, все это случается не всегда и не везде, а описанная ситуация несколько утрирована. Но представители крупных и средних компаний, вероятно, непонаслышке знакомы с такой ситуацией.

Все можно изменить. Для этого стоит попробовать то, о чем шла речь выше — MaaS. Все отдельные сервисы мониторинга будут собраны в единое целое, систему, где все взаимодействует со всем. Причем MaaS поможет вашему ИТ-отделу выполнять свои прямые обязанности, а не заниматься обслуживанием сторонних систем.

Вот несколько вещей, которые стоит знать о MaaS перед тем, как начать работу с такой системой:

MaaS довольно просто развернуть. Конечно, всю систему реализовать несколько сложнее, чем каждый из упомянутых выше сервисов или программных продуктов. Но сделав это раз, вы получите полноценную систему мониторинга всей вашей сетевой инфраструктуры на корпоративном уровне. Специалисты говорят, что MaaS можно установить и сконфигурировать всего за сутки, после чего система начнет работу.

MaaS легко можно модифицировать. Без MaaS изменять что-то в сервисах монитоинга не так просто. Сделав одно изменение, нужно затем следить за тем, чтобы оно не повлияло негативным образом на работу других систем. Все это делается совсем вручную или в полуавтоматическом режиме. А вот с MaaS все относительно просто — такие изменения реализуются в одном месте, и система сама подстраивается под текущую модификацию.

Такая система обычно представляет собой виртуальную модель физической сетевой инфраструктуры. Каждое устройство, приложение, софтверное решение или «железный» продукт отслеживаются. Так что изменения, сделанные «сверху», затем автоматически вносятся системой на всех других уровнях инфраструктуры, включая как программные, так и аппаратные продукты.

Отчетность становится проще. Одна из главных проблем работы с несколькими сервисами мониторинга одновременно — необходимость получения отчетов. Данные могут присылаться в автоматическом режиме, но их много, и они относятся к различным секторам и аспектам работы сетевой инфраструктуры.

MaaS же дает отчет по работе всей инфраструктуры в целом, а не по отдельным ее разделам. Отправку отчетов можно гибко настроить на определенный период времени, с включением данных по разным системам. Работа любого приложения или устройства может быть включена в отчет.

Проблема в работе с разными сервисами еще в том, что у всех у них разный интерфейс, по-разному собираются и отправляются данные. А поскольку такие сервисы или приложения редко взаимодействуют друг с другом (об этом мы говорили выше), то работа со всем этим «зверинцем» — та еще проблема, которая усиливается по мере роста сетевой инфраструктуры компании.

У компаний, предоставляющих услуги MaaS, обычно большой опыт. Благодаря этому они знают, за работой каких сервисов или приложений необходимо следить в первую очередь, а также то, как и когда собирать данные об их работе. Все это можно поручить собственному ИТ-отделу, но это влечет за собой проблему, описанную в самом начале.

Поддержка со стороны. Используя MaaS, вы автоматически получаете и поддержку той компании, которая предоставляет эту услугу. Все вопросы и проблемы относительно мониторинга можно решать с этой компанией. А собственный ИТ-отдел будет заниматься тем, чем и должен — проектами и задачами собственной компании, а не мониторингом сервисов и программ мониторинга.

В качестве вывода можно сказать, что любая компания должна отслеживать работу своих продуктов. Но вот наблюдение за сервисами мониторинга лучше делегировать кому-то еще. В противном случае ИТ-отдел будет тратить большое количество времени и усилий на работу, которая не является задачей первоочередной важности.

Сегодня я расскажу тебе, как при помощи напильника, кучки серверов и такой-то матери собрать что-то смутно похожее на EC2 от Amazon.

Статья получилась больше обзорная, так что придётся разбить её на несколько частей.

Я тебя слепила из того что было.

Это — демостенд, 6 х i5-3570T/8Gb RAM/рассыпуха всяких дисков.

Как-то встала у меня задача упорядочить все офисные сервисы, хаотично разбросанные по зоопарку серверов и операционок (у меня тут даже OpenBSD где-то бегает). И так вышло, что я давно хотел посмотреть на облака, а реального тесткейса не было. Так я и решил изучить, что нынче есть интересного в мире open-source и можно ли это применить в боевых условиях.

На текущий момент я посмотрел такие решения как MaaS + Juju имени Cannonical, RDO имени RedHat, Foreman с плагином и Fuel.

Забегая немного вперёд — Fuel для меня оказался самым адекватным, но пройдёмся по порядку.

MaaS

Простой и аскетичный дизайн

MaaS представляет собою концепцию Metal as a Service, по сути — занимается менеджментом «голого» железа. Вы можете выбрать какую версию убунты установить на тот или иной сервер, узнать его ТТХ и по сути всё. Сервера можно разделять по регионам доступности. Так же умеет работать с виртуалками через libvirtd. Интересное начинается когда вы прикручиваете ко всему этому Juju — теперь вы можете сказать «установи мне бложек» и оно выберет из списка доступного метала железку и накатит туда весь необходимый софт, как то mysql, apache, wordpress/drupal/etc. Мило, удобно, но когда я попытался подобным образом развернуть OpenStack, всё встало колом. Возможно я делал что-то не так, возможно что-то не так делали создатели конфигов для juju. Но в итоге мне не удалось нормально развернуть контроллер на одном сервере. Под каждый компонент контроллера оно хотело отдельную железку. Т.е. нужен вам keystone?, не вопрос — вот отдельный сервер под keystone. И так со всем. Ко всему этому добавилась моя нелюбовь к ubuntu как серверной ОС, так что решение пришлось отложить.

RDO

Foreman

Тысячи графиков, начальство будет счастливо

Сам по себе The Foreman это вебинтерфейс для управления puppet'овыми конфигами и в этой роли он вполне удобен и интересен. Но помимо этого он умеет и provisioning. Так что, как и с MaaS, вы можете сказать серверу грузиться по сети, а дальше управлять установкой через удобную вебморду. Имея такое удобное решение сложно было не прийти к идее разворачивания клауда на его основе. И всякие народные умельцы начали это потихоньку реализовывать. На текущий момент в nightly build'ах есть плагин foreman-installer-staypuft. С его помощью вы устанавливаете как сам Foreman, так и необходимые плагины. Удобство этой конструкции в том, что буквально из одной точки вы можете установить ОС (причём как Linux-based, так и Windows), после чего раздать нужные роли и установить необходимый набор софта. Или развернуть клауд, и опять же из вебморды foreman'а назначить роли для инстансов в этом клауде. Есть только одно существенное НО — ночные сборки достаточно нестабильны.

Возможно со временем это решение доделают и оно будет вполне production-ready, но на текущий момент можно только баловаться и отправлять багрепорты разработчикам. Благо они активно читают гугло-группу.

Fuel

У них похоже есть дизайнер

На текущий момент самое совершенное решение по разворачиванию клауда от достаточно именитой компании Mirantis. По сути — это заточенный исключительно на разворачивания клауда софт. Как и rdo/foreman — делает он это с помощью puppet'овых скриптов. Установка controller + 3 compute node занимает около 30 минут, зависит от скорости ваших винтов. Можно создавать как High availability, так и non-HA кластер. Умеет из коробки работать с Ceph, в версии 5.1 так же добавили драйвера для Mellanox'овых сетевух, что в комбинации LVM+Infiniband позволяет использовать RDMA (пока не проверял в действии, жду когда приедет свитч и сетевухи). Огромным плюсом является наличие большого количества документации.

В следующий раз я расскажу вам что же собственно у меня вышло сделать при помощи Fuel, немного про особенности ceph, как использовать несколько гипервизоров в одном клауде и как упростить себе жизнь автоматизировав всё и вся. А если ко мне таки доедет InfiniBand, то, возможно, и про особенности его работы с ceph и openstack.

Читайте также: