Как увеличить пропускную способность коммутатора

В 2016 году международная организация «Институт инженеров электротехники и электроники» (IEEE) утвердила стандарт IEEE 802.3bz-2016.

СТАНДАРТ IEEE 802.3BZ

Стандарт IEEE 802.3bz определяет следующие варианты:

· Пропускная способность 2,5 Гбит/с на расстояниях до 100 метров с применением кабелей категории 5е.

· Пропускная способность 5 Гбит/с на расстояниях до 100 метров на кабелях категории 6.

· Пропускная способность 5 Гбит/с на расстояниях до 100 (чаще – до 50) метров при использовании кабелей категории 5е «в определенных случаях и конфигурациях развертывания».

· Совместимость со стандартами 100BASE-TX (100 Мбит/с), 1000BASE‑T (1 Гбит/с), 10GBASE-T (10 Гбит/с).

Другими словами, при использовании существующей кабельной системы ( структурированной кабельной системы - СКС) и активного сетевого оборудования , поддерживающего стандарт IEEE 802.3bz, пользователь получает возможность увеличения пропускной способности кабельных каналов без физической замены кабелей.

До появления данного стандарта поддерживались следующие стандарты при определённом типе кабеля:

· кабель категории 5е: 10BASE-T (10 Мбит/с), 100BASE-TX (100 Мбит/с), 1000BASE‑T (1 Гбит/с);

· кабель категории 6: 10BASE-T (10 Мбит/с), 100BASE-TX (100 Мбит/с), 1000BASE‑T (1 Гбит/с), 10GBASE-T (10 Гбит/с, имеются ограничения по длине кабеля 55 метров).

· кабель категории 6а: 10BASE-T (10 Мбит/с), 100BASE-TX (100 Мбит/с), 1000BASE‑T (1 Гбит/с), 10GBASE-T (10 Гбит/с).

В КАКИХ СЛУЧАЯХ АКТУАЛЬНО ПРИМЕНЕНИЕ IEEE 802.3BZ?

· Переход на стандарт 10GBASE-T (10 Гбит/с) не обоснован или избыточен;

· прокладка новых кабелей категории 6а для компании слишком дорого;

· имеются ограничения по категории и/или длине кабеля.

ПРИМЕРЫ И ВАРИАНТЫ ИСПОЛЬЗОВАНИЯ

1. Компания расширяется, но имеющегося к серверам доступа с пропускной способностью 1Гбит/с пользователям уже не хватает и нет возможности проложить кабель категории 6а и выше (например, арендуемое помещение), чтобы перейти на пропускную способность 10 Гбит/с. При использовании коммутаторов с поддержкой стандарта IEEE 802.3bz пропускная способность каналов связи увеличится до 2,5Гбит/с на кабелях категории 5е.

2. Компания имеет сервер, подключенный к коммутаторам с пропускной способностью 10Гбит/с. Конечные пользователи подключены через кабели категории 5е и коммутаторы пропускной способностью 1Гбит/с на 1 порт. При необходимости более высокой пропускной способности от пользователя к серверу требуется перепрокладка кабеля более высокой категории. В случае использования коммутаторов стандарта IEEE 802.3bz пропускная способность может быть увеличена до 2,5/5Гбит/с в зависимости от имеющегося кабеля передачи данных и его длины.

3. Компания имеет системы хранения данных (СХД), подключенные к серверам/коммутаторам по протоколам iSCSI/CIFS/NFC с пропускной способностью 10Гбит/с или выше (либо по протоколу FC с пропускной способностью 8/16/32Гбит/с ), но далее к потребителям поступают данные по каналам связи с пропускной способностью 1Гбит/с. В этом случае использование возможностей стандарта IEEE 802.3bz позволит существенно увеличить скорость доступа к ресурсам данных на СХД: 2,5Гбит/с или 5Гбит/с в зависимости от длины и категории используемого кабеля.

4. Имеется система IP-видеонаблюдения . Кабельная система построена ка кабеле категории 5е. Изменилось количество либо камеры заменены на новые (с более высоким разрешением), как следствие – увеличился видеопоток с коммутаторов камер видеонаблюдения. Достаточного ранее потока 1Гбит/с, поступающего на центральный пост, перестало хватать, наблюдаются задержки и потери пакетов. В этом случае вместо перекладки кабеля категории 5е на кабель категории 6 и замены коммутаторов на модели с поддержкой 10Гбит/с достаточно заменить имеющиеся коммутаторы на новые, поддерживающие стандарт IEEE 802.3bz, что обойдётся существенно дешевле.

5. Имеется система Wi-Fi . Кабельная система построена на кабеле категории 5е. Изменилось количество точек доступа, либо точки доступа заменены на новые с более высокой пропускной способностью, например, ac Wave2. Как следствие – значительно увеличился сетевой поток с точек доступа и с коммутаторов точек доступа. Достаточного ранее потока в 1Гбит/с, поступающего на контроллер Wi-Fi сети либо коммутаторы Wi-Fi сети, перестало хватать, в результате чего наблюдаются задержки и потери пакетов. В этом случае замена, имеющихся коммутаторов на новые, поддерживающие стандарт IEEE 802.3bz, обойдётся существенно дешевле перекладки кабеля категории 5е на кабель категории 6 и покупки новых коммутаторы 10 Гбит/с.

Стоит отметить, что стандарт IEEE 802.3bz поддерживает электропитание оконечных устройств по стандарту PoE 802.3af/at (до 30 Вт на порт), что немаловажно при условии подключения оконечных устройств через технологию РоЕ.

Ведущие компании-производители активного сетевого оборудования уже выпускают коммутаторы с поддержкой стандарта IEEE 802.3bz по доступной цене. Это означает, что для компаний, не имеющих возможность замены кабелей СКС, существует недорогое решение для увеличения пропускной способности каналов связи в 2,5-5 раз без замены кабельной системы вычислительной сети.

УСЛУГИ 2В СЕРВИС

Компания 2В Сервис оказывает комплексные услуги по проектированию, монтажу и обслуживанию Структурированных кабельных систем и обеспечивает техническую поддержку сетевой инфраструктуры для предприятий различного масштаба и профиля деятельности.

Мы будем рады предоставить вам консультацию или предварительный расчет стоимости. Для этого следует обратиться к нашим менеджерам:

Агрегация каналов-это подход к объединению нескольких отдельных каналов (Ethernet) в один логический канал. Вместе с ним часто появляются два термина, то есть LAG и LACP. Они вас смутили? Давайте теперь немного подробнее рассмотрим эти термины.

Не стесняйтесь забегать вперед, если вы уже позаботились о некоторых деталях.

Что такое LAG и как это работает?

LAG (Link Aggregation Group) - это реальный метод или пример для агрегации каналов. Группа агрегации каналов формируется, когда мы подключаем несколько портов параллельно между двумя коммутаторами и настраиваем их как LAG. LAG создает несколько каналов между двумя коммутаторами, что увеличивает пропускную способность.

Кроме того, он обеспечивает резервирование на уровне канала при отказе сети и балансировке нагрузки трафика. Даже если одна связь выйдет из строя, остальные связи между двумя коммутаторами все равно будут работать. Они также принимают на себя тот трафик, который должен проходить через вышедшего из строя, поэтому пакет данных не будет потерян.

Что такое LACP (протокол управления агрегацией каналов) и как он работает?

LACP - это подкомпонент стандарта IEEE 802.3ad (Link Aggregation).Стандарт предписывает, что LACP может быть методом объединения нескольких физических каналов между сетевыми устройствами в один логический канал.

В результате, каналы, поддерживающие протокол LACP, могут увеличить логическую полосу пропускания и надежность сети без изменения какой-либо сетевой инфраструктуры.

Более того, даже если одна ссылка выходит из строя, в режиме LACP другие доступные члены ссылки в той же группе LACP будут балансировать нагрузку.

В момент, когда LACP включен между двумя коммутаторами, они будут отправлять LACPDU (блоки данных LACP) друг другу. После получения друг от друга LACPDU два коммутатора будут определять, у какой стороны системный приоритет выше.

Затем они будут вести переговоры друг с другом, чтобы выбрать того, кто выше, чтобы быть Актером, а тот, кто ниже, - Партнером. Если два коммутатора имеют одинаковый системный приоритет, коммутатор с меньшим значением MAC-адреса будет Актером.

После выбора Субъекта два коммутатора будут выбирать активные порты на основе приоритетов портов порта Субъекта. Однако, если порты Субъекта имеют одинаковые приоритеты, порты с меньшими номерами портов будут выбраны в качестве активных портов.

После выбора соответствующих портов двух коммутаторов устанавливается порт-канал (группа LACP). Тогда активные ссылки загрузят данные баланса для связи.

LAG vs LACP: в чем разница?

LAG (link aggregation group) относится к исходной технологии для реализации объединения каналов и балансировки нагрузки без участия какого-либо протокола. Он также называется ручным режимом из-за его рабочего процесса - пользователям необходимо вручную создать порт-канал и добавить интерфейсы-элементы к этому порту-каналу.

После того, как каналы агрегации установлены, все эти ссылки становятся активными ссылками для пересылки пакетов данных. Если одна активная ссылка не работает, остальные оставшиеся активные ссылки будут балансировать нагрузку на трафик. Однако этот режим может обнаруживать только разъединения входящих в него каналов, но не может обнаруживать другие сбои, такие как сбои канального уровня и неправильные соединения каналов.

LACP - это протокол для автоматической настройки и поддержки LAG. В режиме LACP порт-канал создается на основе LACP. LACP предоставляет стандартный механизм согласования для коммутационного устройства, так что коммутационное устройство может автоматически формировать и запускать агрегированный канал в соответствии с его конфигурацией. После того, как агрегированный канал сформирован, LACP отвечает за поддержание статуса канала.

Когда условие агрегирования ссылок изменяется, LACP корректирует или удаляет агрегированный канал. Если одна активная ссылка выходит из строя, система выбирает ссылку среди резервных ссылок в качестве активной ссылки. Таким образом, количество ссылок, участвующих в пересылке данных, остается неизменным. Кроме того, этот режим не только обнаруживает разъединения своих звеньев, но и другие сбои, такие как сбои канального уровня и неправильные соединения каналов.

Должен ли я включать агрегацию каналов?

Если у вас есть коммутатор с большим количеством портов Gigabit Ethernet, вы можете подключить их все к другому устройству, у которого также есть несколько портов, и сбалансировать трафик между этими каналами для повышения производительности.

Другой важной причиной использования агрегации каналов является обеспечение быстрого и прозрачного восстановления в случае отказа одного из отдельных каналов.

Если вы очень заботитесь о надежности и доступности сети, было бы лучше включить агрегацию каналов на ваших устройствах.

Как настроить коммутатор агрегации каналов?

Коммутатор агрегации каналов или коммутатор LACP, см. Установку или настройку коммутатора для достижения технологии агрегации каналов. Коммутатор агрегации каналов может быть любым коммутатором, например Gigabit Ethernet коммутатор или 10 Gigabit коммутатор, который поддерживает LACP. Как правило, существует шесть шагов для настройки коммутаторов агрегации каналов:

Шаг 1. Добавьте интерфейсы участников в группу каналов.

Шаг 2: Установите приоритет системы LACP и определите Субъекта, чтобы Партнер выбирал активные интерфейсы на основе приоритета интерфейса Субъекта.

Шаг 3: Установите верхний порог количества активных интерфейсов для повышения надежности. (Этот шаг необязательно применяется в командах динамической конфигурации CLI.)

Шаг 4: Установите приоритеты интерфейса LACP и определите активные интерфейсы, чтобы интерфейсы с более высоким приоритетом выбирались в качестве активных интерфейсов. (Этот шаг необязательно применяется в командах динамической конфигурации CLI.)

Шаг 5: Создайте сети VLAN и добавьте интерфейсы к этим VLAN. (Этот шаг необязательно применяется в командах динамической конфигурации CLI.)

Шаг 6: Проверьте конфигурацию LACP.

Дополнительные сведения о настройке коммутатора LACP или коммутатора агрегации каналов см. В разделе Конфигурация LACP на коммутаторах серии FS S3900.

Коммутаторы поддерживающие LAG

Если вы ищете хорошие сетевые коммутаторы, поддерживающие LACP, вот три самых продаваемых коммутатора от FS, глобальной высокотехнологичной компании, предоставляющей решения и услуги для высокоскоростных сетей связи.

| S3900-24T4S | S5850-48S6Q | S5860-20SQ | |

|---|---|---|---|

| Уровень управления | Layer 2+ | Layer 3 | Layer 3 |

| Комбинация портов | 24 x 1G, 4 x 10G SFP+ | 48 x 10G SFP+, 6 x 40G QSFP+ | 20 x 10G SFP+, 4 x 25G SFP28, 2 x 40G QSFP+ |

| Ключевая особенность | VLAN, QoS, IGMP Snooping, Link Aggregation, IPv6,L3 статическая маршрутизация | VLAN, QoS, IGMP Snooping, Link Aggregation, статическая маршрутизация, RIP, OSPF, IPv6 поддержка, BGP/ISIS, MLAG | QoS, IGMP Snooping, Link Aggregation, IPv6, L3 статическая маршрутизация, RIP, OSPF, BGP/ISIS, стекируемый |

| Применения | SMB(<300 пользователей) | Предприятие (300-2500 пользователей) | Среднее & крупное предприятие (>2500 пользователей) |

Заключение

Вы получили представление об агрегирования каналов, LAG и LACP? Сможете ли вы использовать их с пользой и найти сетевой коммутатор, который вам подойдет? Агрегация каналов - это способ объединения нескольких отдельных (Ethernet) каналов, чтобы они могли работать как единое логическое соединение. Группа портов, объединенных вместе, называется группой агрегации каналов или LAG. Протокол активного мониторинга, который позволяет устройствам включать или удалять отдельные ссылки из LAG, называется протоколом управления агрегацией каналов (LACP).

Шаг 1. Проверьте скорость вашего подключения по локальной сети между компьютером и коммутатором.

Если скорость соединения «нормальная» (почти совпадает со скоростью, которую получает ваш компьютер от роутера напрямую), то перейдите к шагу 2.

Если скорость соединения «низкая» (к примеру, вы получаете только 100 Мбит/с, но ваша сетевая карта и роутер – гигабитные) – ваш коммутатор и роутер (или коммутатор и компьютер) подключились не корректно.

Примечание: наши неуправляемые коммутаторы работают в режиме авто-согласования скорости. Для этого необходимо, чтобы ваш роутер или сетевая карта компьютера также работали в режиме авто-согласования и были подключены кабелем стандарта EIA/TIA-568.

- Скорость соединения обычно не настраивается в настройках роутера (уточните у технической поддержки вашего роутера, возможно ли изменить режим работы на авто-согласование или вручную указать скорость большего значения)

- Что касается скорости соединенияна компьютере, то обычно в настройках сетевой карты есть возможность изменить скорость и тип дуплекса (speed and duplex):

На компьютере откройте Подключение по локальной сети, нажмите по нему правой кнопкой мыши, перейдите во вкладку Свойства – Настройка – Дополнительно – Скорость и Дуплекс – Первым делом выберите режим «Автоматически», «Авто-согласование» или “Auto-mode”. Если изменений нет, попробуйте разные скорости с разными дуплексами пока не увидите, что скорость соединения увеличилась.

- Убедитесь, что ваш кабель EIA/TIA-568 не повреждён, и жилы кабеля плотно закреплены к коннектору.

Шаг 2. Если скорость соединения сетевой карты вашего компьютера нормальная, то выполните следующие действия:

- Подключите два компьютера к вашему коммутатору через кабель, отключив при этом все остальное из коммутатора.

- Попробуйте передать какой-либо файл с одного компьютера на другой (к примеру, через программу передачи данных Dukto R6) и замерьте скорость.

Примечание: если скорость передачи файла будет быстрее чем скорость загрузки при подключении к роутеру напрямую, значит, коммутатор исправен, и вам необходимо проверить настройки вашего роутера.

Приветствую всех. Сегодня я постараюсь внести ясность в такую неоднозначную и вызывающую много споров тему, как агрегирование каналов в Vmware. Многие (в том числе и производители оборудования) для описания агрегирования каналов применяют такие термины как LACP, 802.3ad, Ethernet trunk, NIC Teaming, Port Channel, Port Teaming, Link Bundling, NIC bonding, EtherChannel, link aggregation и некоторые другие. В целом, технология агрегирования каналов, это технология позволяющая объединить несколько физических каналов в один логический. Такое объединение позволяет увеличивать пропускную способность (он же Load Distribution или Load Balancing) и надежность канала (она же Failover). В данной статье, возможно, я сделал какие-то неверные выводы и буду благодарен за дополнения и комментарии. Для написания статьи я придерживался мануала Cisco IEEE 802.3ad Link Bundling, ибо только в нем нашел более менее систематизированные понятия.

Введение в агрегирование каналов (NIC Teaming)

Для начала, давайте разберемся в терминологии. В связи с большой путаницей в понятиях, я буду придерживаться следующего списка:

Агрегирование каналов - собственно, общее наименование любого из видов объединения физических каналов в логический.

EtherChannel - это просто название технологии Cisco, описывающей агрегацию каналов (не протокол ил стандарт).

Teaming (или NIC Teaming) - по аналогии с Cisco, это так же название технологии агрегации каналов в компании Vmware (и некоторых других, например Intel и HP).

Link Aggregation Control Protocol (LACP) - протокол агрегации каналов, имеющий возможности автоматически создавать агрегацию (посредством пересылки LACP PDU пакетов). Протокол LACP описан в стандарте IEEE 802.3ad (как утверждает Microsoft, он же имеет маркировку IEEE 802.1ax, хотя в Cisco я не нашел упоминания 802.1ax).

IEEE 802.3ad - стандарт, описывающий протоколы и принципы агрегирования каналов. Так же, включает описание балансировки трафика агрегированных каналов.

LAG (Link Aggrigation Group) - в терминологии Vmware это и есть логический канал, объединяющий в себе uplink порты.

Далее, давайте рассмотрим что же такое агрегирование каналов без привязки к производителю. Из терминов выше - ясно, что это технология объединения физических интерфейсов в логический. Какую-то часть функционала данной технологии выполняет протокол STP, позволяющий использовать несколько физических интерфейсов для отказоустойчивости. Но данный протокол не позволяет осуществлять балансировку трафика и по сути в какой-то один момент времени использует только один физический линк для передачи данных. Хотя агрегирование позволяет увеличить пропускную способность канала, но не стоит рассчитывать на идеальную балансировку нагрузки между всеми интерфейсами в агрегированном канале. Технологии по балансировке нагрузки в агрегированных каналах, как правило, ориентированы на балансировку по таким критериям: MAC-адресам, IP-адресам, портам отправителя или получателя (по одному критерию или их комбинации). Агрегирование каналов у многих производителей сетевого оборудования возможно только в режиме "точка-точка". То есть возможно агрегировать каналы начинающиеся на одном устройстве и заканчивающиеся на другом устройстве. Т.к. цель данной статьи - рассмотреть NIC Teaming на Vmware, то для упрощения будем придерживаться ситуации, когда наш хост использует один физический коммутатор для агрегирования каналов.

Какие же требования необходимо выполнить, чтобы агрегирование каналов заработало корректно?

- Максимальное количество поддерживаемых интерфейсов в агрегированном канале определяется производителем оборудования. (наиболее частая цифра 4 или 8 интерфейсов, в Vmware на текущий момент - 32)

- Все физические интерфейсы в агрегированном канале должны иметь одинаковые настройки скорости и режима full-duplex. (при этом, LACP не поддерживает half-duplex mode).

- Все физические интерфейсы в агрегированном канале должны иметь одинаковые настройки протокола агрегирования (LACP, статический и др.).

- VMware поддерживает только один канал EtherChannel на vSwitch или vNetwork Distributed Switch (vDS)

Режим работы EtherChannel

Теперь давайте рассмотрим нюансы работы протокола LACP на примере оборудования Cisco (имеющие отношение к Vmware vSphere). Итак, оборудование Cisco, поддерживающее EtherChannel может настроить этот самый EtherChannel в нескольких режимах. За это отвечает команда channel-group (подробней - в ссылках в документе IEEE 802.3ad Link Bundling). Из всех возможных режимах в Cisco, Vmware поддерживает только 3 (до версии 5.5 - только 1). Рассмотрим режимы EtherChannel :

channel-group номер_группы mode active

Данный режим включает Link Aggregation Control Protocol (LACP) на интерфейсе постоянно . То есть Cisco в любом случае является источником LACP PDU пакетов. Скажем так - является активным инициатором.

channel-group номер_группы mode passive

LACP включается только когда обнаружено поступление LACP пакетов от другой стороны. Скажем так - является пассивным инициатором.

channel-group номер_группы mode on

Данный режим включает EtherChannel без использования каких-либо протоколов согласования . Это так называемый статический EtherChannel или статический NIC Teaming или статическая агрегация. Назвать данный режим LACP - нельзя. Т.к. для его работы не используется функционал протокола LACP. Т.е. не происходит автоматического согласование канала на основе обмена LACP пакетами.

channel-group номер_группы mode

Это другие возможные режимы работы, но они нам не интересны, т.к. используют для согласования проприетарный протокол PAgP и vSphere не поддерживаются.

Работа протокола LACP будет возможна, при следующих конфигурациях сторон:

То есть, не работающая конфигурация, когда обе стороны настроены в LACP passive режиме. Статическая агрегация IEEE 802.3ad возможна только когда обе стороны настроены в статическом режиме.

Балансировка нагрузки EtherChannel

Например, на схеме, все устройства находятся в одном VLAN. Шлюз по умолчанию маршрутизатор R1. Если коммутатор sw2 использует метод балансировки по MAC-адресу отправителя, то балансировка выполняться не будет, так как у всех фреймов MAC-адрес отправителя будет адрес маршрутизатора R1. Аналогично, если коммутатор sw1 использует метод балансировки по MAC-адресу получателя, то балансировка выполняться не будет, так как у всех фреймов, которые будут проходить через агрегированный канал, MAC-адрес получателя будет адрес маршрутизатора R1.

Агрегация каналов ( NIC Teaming ) в VMware

Начнем с истории, а точнее, с версий vmware - до 5.5. Официально, до версии 5.5 в vSphere отсутствовала поддержка агрегирования каналов по протоколу LACP. Можете сравнить документы what's new для версии 5.1 и 5.5. Хотя, в документации vSphere Networking Guide ESXi 5.1 уже есть упоминание о включении LACP на uplink интерфейсе. Будем считать, что полноценна поддержка появилась в 5.5.

NIC Teaming в Vmware vsphere до 5.5 (5.1.x, 4.x)

Примеров данных конфигураций в интернете полно. Пожалуй, лучшая статья, которая в достаточной степени описывает технологию и настройку NIC Teaming на Vmware (для версий VMware ESX 3.0.x,VMware ESX(i) 3.5.x, VMware ESX(i) 4.0.x, VMware ESX(i) 4.1.x, VMware ESXi 5.0.x и VMware ESXi 5.1.x) размещена на сайте Михаила Михеева - LACP, 802.3ad, load based IP hash и все такое (см.ссылки). Копипастить одно и то же смысла не вижу, поэтому - читайте ). Если все же есть непреодолимое желание использовать LACP с vSphere младше 5.5, вам потребуется установить виртуальный коммутатор Cisco Nexus 1000V (или IBM 5000v).

NIC Teaming по протоколу LACP в Vmware vsphere 5.5.x

VMware ESXi 5.5.x, как и прошлые версии поддерживает работу в режиме статического тиминга. Настройка его ни чем не отличается от той, которая написана в статье LACP, 802.3ad, load based IP hash и все такое. Далее, нас интересует настройка NIC Teaming с использованием согласования по протокол LACP на Vmware. В чем же польза LACP по сравнению с static aggregation:

-

Возможность использовать Hot-Standby Ports. Если добавить физических портов больше чем поддерживает оборудование (по крайне мере в cisco), то есть возможность использовать лишние порты в качестве портов hot-standby mode. Если произойдет отказ активного порта, порт hot-standby автоматически заменит его. Этот пункт мало применим к ESX, но тем не менее.

Проверка корректности конфигурации. Агрегация каналов

Failover (обнаружение отказа). Если у вас имеется dumb-устройство между двумя концами EtherChannel, например media converter, и один из линков, идущих через него отказывает, LACP это понимает и перестает слать трафик в отказавший линк. Static EtherChannel не мониторит состояние линков. Это не типичная ситуация для большинства систем vSphere, которые мне встречались, но в ряде случаев это может оказаться полезным.

Архитектурно, LACP'ом в vSphere управляет модуль ядра, который взаимодействует с демоном lacp _ uw. Ключевое отличие настройки статической агрегации от LACP на vSphere Distributed Switch заключается в следующем: При использовании NIC teaming в статической конфигурации на vSphere Distributed Switch мы создавали т.н. Uplink порты, которым сопоставляли физические vmnic интерфейсы хостов. А уже Uplink интерфейс использовали в качестве исходящего интерфейса взаимодействия с внешним миром. А виртуальные машины, работая на каком-либо из хостов выбирали из ассоциированного с Uplink физического интерфейса - нужный. При этом, группировка и балансировка происходила на уровне созданных Uplink интерфейсов в настройках распределенных порт-групп в разделе “Teaming and failover”. При настройке Link Aggregation Control Protocol мы создаем т.н. LAG (Link Aggrigation Group) - некая сущность, аналогичная Port Channel в Cisco - логический интерфейс, который объединяет физические интерфейсы и на уровне которой применяются настройки LACP (active-passive) и Load Balancing, к которой ассоциируются физические интерфейсы одного хоста. А Уже к этому самому LAG присоединяются/ассоциируются физические vmnic интерфейсы. И этот же LAG используется в качестве исходящего интерфейса. "На пальцах" тяжело понять данный абзац. Необходима практика )

Типовой пример настройки NIC Teaming по протоколу LACP

Давайте на практике посмотрим как это выглядит. Предположим, что у нас уже создан некий Distributed Switch 5.5.0. Со свичом ассоциированы необходимые хосты. Создана некая портгруппа виртуальных машин в конфигурациях по умолчанию. Например:

Далее, перед настройкой LACP давайте рассмотрим некоторые аспекты настройки:

- Из физических NIC какого-то одного хоста возможно подключение одного физического NIC только к одному порту LAG, при этом, один порт LAG может включать в себя множество физических интерфейсов с различных хостов ассоциированных с данным распределенным коммутатором.

- Физические NIC хоста, включенные в LAG должны быть подключены к интерфейсам физического свича, которые (интерфейсы свича) должны быть настроены на аналогичный агрегированный канал (port channel).

- При настройке LACP необходимо учитывать ограничения, актуальные для текущей версии:

LACP не совместим с software iSCSI multipathing.

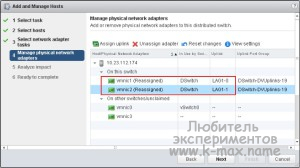

Итак, последовательность настройки LACP на Vmware следующая:

Назначить LAG как Standby интерфейс в настройке Teaming and Failover Order в Distributed Port Group.

Это рекомендованная мануалом последовательность. На самом деле, можно обойтись без шага №2. Просто задав ассоциацию свободных физических NIC к созданному LAG. Но тем не менее, давайте рассмотрим каждый шаг:

В vSphere Web Client переходим на наш созданный distributed switch.

![ассоциировать uplink с LAG в LACP]()

Ассоциировать физические интерфейсы с LAG

- . Убеждаемся, что все порты, которые планируется ассоциировать с LAG сконфигурированы и скоммутированы на физическом коммутаторе.

- . Убеждаемся, что все физические NIC имеют одинаковые настройки скорости и

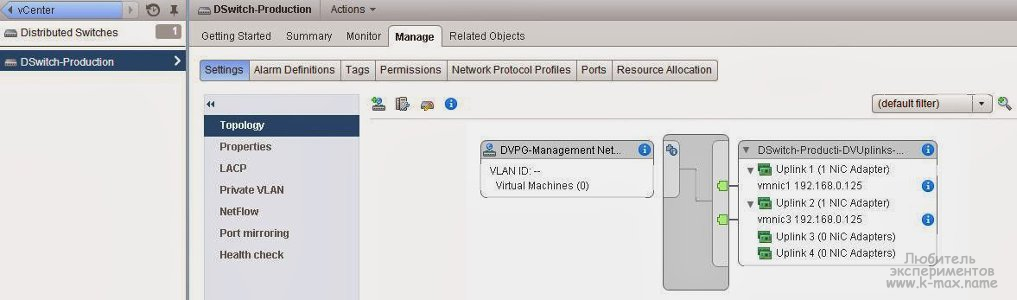

В поле Failover order с помощью стрелок перемещаем наш созданный LAG в раздел Active, все остальные аплинки (если такие имеются) перемещаем в

![distributed switch LAG uplunk]()

Резюме

В текущей статье я постарался описать особенности работы с агрегированными каналами. Постарался описать статическую конфигурацию NIC Teaming и конфигурацию по протоколу LACP. Упор сделан не столько на практику, сколько на теорию и предоставление источников дальнейшего чтения для углубления изучения ) ИМХО, обзор получился несколько поверхностным, по возможности буду наполнять статью.

Читайте также: