Если монитор 75 герц сколько ставить фпс

На что способен человек

С самого начала развития кинематографа и анимации появился миф о том, что 24 кадра в секунду — максимум, что может распознать человек. Якобы делать больше нет абсолютно никакого смысла, и визуально плавность анимации никак не изменится.

Для человека слайдшоу превращается в анимацию уже на частоте примерно 15 кадров в секунду. Но чем выше частота кадров, тем лучше воспринимается картинка. А 24 кадра никак не связаны с физиологией. В основе такого формата больше лежит экономические и технические моменты — киноплёнка тех времён и оборудование для воспроизведения были наилучшими по соотношению цена-качество.

С развитием технологий люди создали новые носители, аналоговые передачи сменились цифровыми: мы смогли перейти на 30 кадров в секунду и больше. Например, система IMAX воспроизводит 48 кадров в секунду, а трансляции игр на Twitch — до 60 FPS. И только скажите, что не замечаете, как картинка на 60 кадров в секунду становится плавнее, чем на 30!

После 60 FPS разницу на большей частоте при просмотре видео уловить сложнее. Тут больше зависит от индивидуального восприятия каждого человека. Например, в американских ВВС проходил тест среди пилотов истребителей. И те умудрялись не просто заметить самолёт, который отображался за один кадр в видеоряде с частотой 220 кадров в секунду, но и назвать его модель. Так что точного ответа на вопрос, сколько кадров распознаёт человек, не существует.

На что способен монитор

Сейчас у большей части мониторов частота обновления равна 60 Гц. Но технологии ушли вперёд, и мы уже можем делать матрицы, которые будут выдавать и 120 Гц, и 144, и даже 240. Но зачем? Мониторы с большой частотой стоят значительно дороже, а пользу ощущают далеко не все. У современного видео частота не превышает 60 кадров в секунду, а значит, и спрос на мониторы с большей частотой обновления невелик.

Но если мы говорим об играх, то они выдают гораздо большие значения FPS, чем видеоконтент. В Counter-Strike: Global Offensive, например, частота и вовсе не ограничена. А самые искушённые игроки ощущают лаги меньше чем при 300 FPS. Чтобы эти кадры в секунду использовались с максимальной эффективностью, нужен монитор с большей частотой обновления.

Приведём простой пример. В первом случае вы сидите и смотрите со стороны, как кто-то играет в CS:GO на мониторе с частотой обновления 144 Гц и с 300 FPS, а рядом сидит человек с монитором на 60 Гц и 60 FPS в игре. Очевидной разницы в изображении для вас не будет никакой. Но если вы сядете на места игроков, то вы сразу почувствуете, что всё происходит чётче, плавнее и точнее.

Это можно доказать и на цифрах. При частоте 60 Гц кадр меняется каждые 16 мс, а при 144 Гц — каждые 6 мс. Несмотря на то что почти трёхкратная разница вообще не будет заметна глазу, мелкая моторика человека после нескольких лет оттачивания мастерства игры использует эти 10 мс для более точного наведения прицела на голову. Это невозможно объяснить словами, только прочувствовать. Все киберспортсмены, кстати, требуют от организаторов использовать мониторы со 144 Гц.

Во-первых, разница между любым профессиональным игроком и его оппонентом настолько мизерна, что даже такие мелочи могут решить исход сражения. Во-вторых, они играют на такой частоте везде — дома, на буткемпе и на других турнирах. За долгое время они привыкли к 144 Гц. На меньшей частоте они не просто не смогут реализовать свой потенциал и будут чувствовать сильный дискомфорт. Им будет казаться, что всё тормозит и лагает.

Кадры лишними не бывают

Может ли монитор с 60 Гц отобразить больше 60 кадров в секунду? Нет, не может. Другой вопрос, что именно он отобразит. Вывод изображения на экран и рендер кадров на компьютере не происходят одновременно. Существует небольшая задержка, которая называется Input Lag. Когда вы двигаете мышкой или нажимаете клавишу, на экране это применится только в следующем кадре.

Если вы играете на 60 FPS, то минимальная разница между движением и отображением составит примерно 16 мс. Если же частота в два раза больше, то перед показом следующего кадра система успевает зарендерить два, а на экран будет выведен более актуальный. Итого, задержка сокращается вдвое. Исходя из этого напрашивается вывод: больше FPS — это всегда хорошо, вне зависимости от того, какая у монитора частота обновления.

Техника не чит, а инструмент

Что будет, если дать обычному человеку самую крутую кисть, краски, холст и попросить его написать шедевр прямо здесь и сейчас? Очевидно, ничего у него не выйдет. Для того чтобы достичь результата, нужна практика, тренировка и сноровка. Если за тысячу часов в CS:GO на мониторе 60 Гц и с 60 FPS вы так и остались сильвером, то никакие мониторы и показатели FPS не сделают из вас чемпиона мейджора. На результат слишком сильно влияет человеческий фактор — форма, настроение, состояние, реакция и масса других особенностей. Ни в коем случае нельзя сводить всё к техническим аспектам.

Всё зависит от потребностей и возможностей. Некоторых устраивает даже 30 FPS и они не видят смысла тратить несколько тысяч долларов на мощный компьютер с самым новым железом и тем более на монитор с частотой 120 Гц и больше. Другие же чувствуют плохую отзывчивость управления даже на 60 Гц, хотя ни разу не пробовали большую частоту. А на топовом уровне всё должно быть самое лучшее — скилл игроков и условия, в которых они выступают. Для того чтобы они могли реализовать свой потенциал на максимум, им нужны инструменты с максимально возможными характеристиками. Профессионалы в курсе, как реализовывать эти собранные по крупицам миллисекунды, а у равных по скиллу соперников именно они решают исход сражения.

- Если у человека железо меньше выдает fps чем на мониторе герц. будет лагать игра или нет?

- И есть ли смысл покупать с начало такой монитор допустим 144 герц или лучше с начало приобрести по мощнее видеокарту?

1) Где-то будет, где-то не будет. Точнее везде будет, но не везде твой глаз будет это замечать

2) Видеокарту

1) Где-то будет, где-то не будет. Точнее везде будет, но не везде твой глаз будет это замечать

2) Видеокарту

А если включить G-sync исправит ситуацию с более низким Fps и высокой герц. или все равно могут быть лаги?

А если включить G-sync исправит ситуацию с более низким Fps и высокой герц. или все равно могут быть лаги?

Я не знаю что такое G-sync. Предпологаю что это тупа другой метод синхронизации. Если моник не умеет переключаться в 60 или 30 кадров - от лагов тебя ничего не застрахует. Сейчас есть методы половинной синхронизации, что иногда спасает при слабом железе, но это скорее костыль.

Ты бы почитал вообще что такое герцовка и для чего нужна синхронизация кадров

Смысол тебе от видяхи если моник 60 герц не выдаст тебе больше 60+фпса.

Я бы пробовал взять и видяху среднюю и моник скажем хотя бы 120герц

Я не знаю что такое G-sync. Предпологаю что это тупа другой метод синхронизации. Если моник не умеет переключаться в 60 или 30 кадров - от лагов тебя ничего не застрахует. Сейчас есть методы половинной синхронизации, что иногда спасает при слабом железе, но это скорее костыль.

Ты бы почитал вообще что такое герцовка и для чего нужна синхронизация кадров

А если понизить герц. на время улучшит ситуацию?

- И есть ли смысл покупать с начало такой монитор допустим 144 герц или лучше с начало приобрести по мощнее видеокарту?

да, не слушаешь мамкиных экспертов, которые ни разу в жизни не видели 100+ герц и покупаешь моник на 144гц и оргазмируешь от плавной картинки.

- Если у человека железо меньше выдает fps чем на мониторе герц. будет лагать игра или нет?

нет, лаги завязаны на производительности процессора и видеокарты, а не на герцовке монитора. Более высокогерцовый монитор просто будет дублировать недостающие кадры.

А если понизить герц. на время улучшит ситуацию?

Герцовку монитора? Ну если он умеет 60 герц то будет как на обычном монике, правда я хз они вообще умеют так (вроде нет)

Нет разницы между 60 фпс на 60 герц мониторе и 60 фпс на 144 герц мониторе.

- Если у человека железо меньше выдает fps чем на мониторе герц. будет лагать игра или нет?

- И есть ли смысл покупать с начало такой монитор допустим 144 герц или лучше с начало приобрести по мощнее видеокарту?

1 Если у тебя включена вертикальная синхронизация то подлагивать будет, если не включена то никакой разницы не будет

2 Лучше взять мощнее видеокарту

- Если у человека железо меньше выдает fps чем на мониторе герц. будет лагать игра или нет?

- И есть ли смысл покупать с начало такой монитор допустим 144 герц или лучше с начало приобрести по мощнее видеокарту?

1) Зависит только от наличия и типа синхронизации, и от того что ты понимаешь под лагами. Допустим моник у тебя 60гц, игра выдает около 55. Варианта два: ты либо синхронизируешь картинку и тогда у тебя будут микростаттеры (ибо когда монику будет нехватать кадров он будет дублировать старый, у тебя будет 5 фреймов длиной в 32мс вместо стандартных при 60гц 16мс), либо будет тиринг (разрыв картинки ибо вк неуспела дорисовать цельный кадр).

Чем ниже будет твой фреймрейт при тех же 60гц (например 40-45) - тем больше статтеров будет, проще будет залочить на 30 кадрах и играть как консольщики

2) офк видяху, моник лишь выводит то, что нарисовала карта. Если она ничего не нарисовала - не важно что за мон будет.

А если включить G-sync исправит ситуацию с более низким Fps и высокой герц. или все равно могут быть лаги?

Жсинк устраняет обе проблемы, но стоит слишком дорого чтоб думать о нем в бюджетном сегменте.

Т.е с жсинком я например могу спокойно играть при 50фпс, при 45 и тп, но лучше офк вложиться в карту мощнее.

Если моник не умеет переключаться в 60 или 30 кадров

Это какая то феерическая чушь. Моник либо пашет на своей, либо поддерживает адаптивку. Свитч между 30-60 это вертикалка

да, не слушаешь мамкиных экспертов, которые ни разу в жизни не видели 100+ герц и покупаешь моник на 144гц и оргазмируешь от плавной картинки.

без нормальной видяхи он будет оргазмировать только от своей глупой траты денег

Нет разницы между 60 фпс на 60 герц мониторе и 60 фпс на 144 герц мониторе.

тащемто есть, ибо 60 на 144 не делится

1) Зависит только от наличия и типа синхронизации, и от того что ты понимаешь под лагами. Допустим моник у тебя 60гц, игра выдает около 55. Варианта два: ты либо синхронизируешь картинку и тогда у тебя будут микростаттеры (ибо когда монику будет нехватать кадров он будет дублировать старый, у тебя будет 5 фреймов длиной в 32мс вместо стандартных при 60гц 16мс), либо будет тиринг (разрыв картинки ибо вк неуспела дорисовать цельный кадр).

Чем ниже будет твой фреймрейт при тех же 60гц (например 40-45) - тем больше статтеров будет, проще будет залочить на 30 кадрах и играть как консольщики

2) офк видяху, моник лишь выводит то, что нарисовала карта. Если она ничего не нарисовала - не важно что за мон будет.

Жсинк устраняет обе проблемы, но стоит слишком дорого чтоб думать о нем в бюджетном сегменте.

Т.е с жсинком я например могу спокойно играть при 50фпс, при 45 и тп, но лучше офк вложиться в карту мощнее.

Это какая то феерическая чушь. Моник либо пашет на своей, либо поддерживает адаптивку. Свитч между 30-60 это вертикалка

без нормальной видяхи он будет оргазмировать только от своей глупой траты денег

тащемто есть, ибо 60 на 144 не делится

Тоесть если моник будет g-sync то можно будет на нем поиграть со старой видеокартой пока не куплю новую видюху? Лагов с g-sync не будет? Просто покупал недавно видюху нехотелось опять покупать.

Часто на просторах Интернета можно столкнуться с ожесточенными спорами на тему приемлемого значения FPS для комфортной игры. Разброс во мнениях широк и варьируется начиная от 30 кадров в секунду, достигая значений в 144 и выше. Так кто же прав и есть ли единое мнение в этом вопросе?

Что такое FPS и с чем его едят

FPS — frames per second (число кадров в секунду) — параметр, отвечающий за число отдельных изображений, которые появляются на экране за одну секунду времени. Наш мозг, обрабатывая независимые кадры, создает иллюзию непрерывного движения. Чем больше кадров в секунду способен выдать компьютер и воспроизвести монитор, тем более плавным будет казаться увиденное. Низкое число кадров приводит к зависаниям и рывкам изображения.

При анализе производительности в видеоиграх, наибольшее внимание уделяется среднему и минимальному показателям FPS. Среднее значение указывает на производительность в целом, в то время как минимальные показатели нужны для определения способности системы справляться с наиболее загруженными моментами в игре.

В геймерском сообществе существуют устоявшиеся значения стабильного FPS, принимаемого за комфортное в различных играх. Такими значениями являются стабильные 30, 60, 120 и выше кадров в секунду.

30 FPS — достаточно ли?

Значение в 30 кадров в секунду считается минимальным показателем частоты для комфортной игры. Именно на такой частоте обновления работает большинство консольных игр. Исходя из технических особенностей консоли и жанровой направленности будущей игры, разработчик может принять решение пожертвовать показателем FPS ради более красочной картинки или наоборот, убавить графические эффекты для плавности игрового опыта.

Жаркие дискуссии разгораются по поводу так называемого «эффекта кинематографичности», который достигается при игре в 30 FPS. Подобный эффект нельзя назвать абсолютным плюсом, так как его восприятие варьируется от человека к человеку. Несмотря на то, что игра в 30 кадров действительно может в какой-то мере вызвать эффект погружения, преобладающее большинство игроков предпочитает наиболее плавное изображение и отзывчивое управление. Тем не менее, стабильных 30 FPS будет достаточно для комфортного прохождения большинства одиночных игр.

Некоторые могут задаться вопросом: почему именно 30 кадров в секунду принято считать пороговым значением, если, к примеру, те же фильмы воспроизводятся с частотой в 24 кадра в секунду? Дело в том, что помимо вывода изображения игра фиксирует запросы, которые посылает игрок с помощью геймпада, клавиатуры с мышью и других устройств. При понижении числа кадров ниже 30 будет существенной задержка между посылаемым сигналом и его фактическим воспроизведением на экране, так называемый «input lag» (задержка отклика):

От 60 и выше

Разница между 30 и 60 FPS значительна и видна невооруженным взглядом. Изображение воспринимается более плавным, а управление более отзывчивым. 60 FPS принято считать эталоном игровой производительности. На данной частоте комфортно играть во все игры, будь то одиночные или многопользовательские.

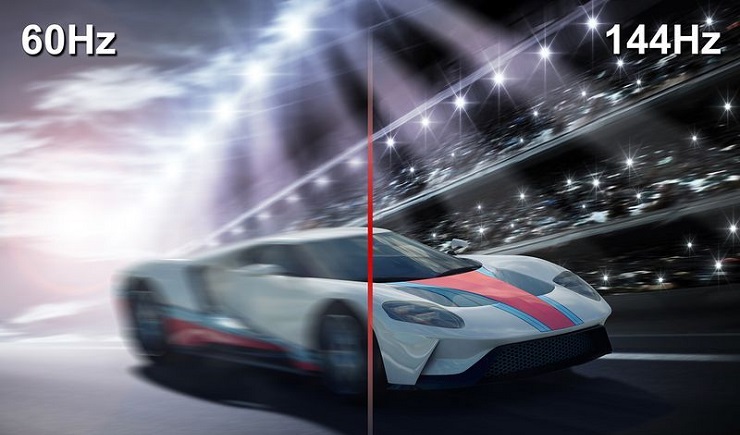

Необходимость в дополнительном повышении частоты кадров возникает при игре в соревновательные мультиплеерные видеоигры, требующие быстрой реакции. В таких играх исход матча зачастую решается за доли секунды. Здесь имеет смысл повышать FPS до максимально возможного значения, так как проще различать движения противников и быстрее на них реагировать. Разницу между плавностью картинки при разных значениях частоты можно пронаблюдать на следующем изображении:

Потребности в FPS в зависимости от жанра

Как упоминалось выше, игровые жанры требуют различного показателя FPS для комфортной игры. Если для прохождения одиночной видеоигры можно ограничиться 30 кадрами, то онлайн-игры, требующие высокой реакции, желательно запускать на частоте кадров от 60 и выше. Из наиболее требовательных к значению FPS жанров можно выделить шутеры от первого лица, ритм-игры, стратегии и игры в жанре MOBA.

Стоит отметить, что частота кадров свыше 60 отображается только на мониторах, поддерживающих повышенную частоту обновления. Например, монитор с частотой в 60 Гц (60 к/с) не может воспроизводить изображение выше собственной. Для игры на высоких показателях FPS необходимо обзавестись специализированным игровым монитором.

Не фреймрейтом единым. Проблемы с изображением помимо FPS

Помимо низкого FPS может возникать большой спектр проблем с изображением. Эти проблемы имеют разные источники, но зачастую их корень кроется в слабых, либо неисправных комплектующих, а также проблемах с Интернетом.

Лаги заключаются в задержке между действиями, которые игрок посылает своему персонажу и их фактическим появлением на экране. Лаги возникают в сетевых играх при задержке сигнала от клиента к серверу. Причиной могут служить как неполадки со стороны клиента, так и со стороны игрового сервера. Немалую роль играет расстояние между игроком и сервером. Именно по этой причине рекомендуется играть на серверах своего региона.

Фризы возникают, когда изображение движется не плавно, а рывками. Причина фризов комплексная и может заключаться в неправильно подобранных игровых настройках, слабом или неисправном железе, а также в устаревших драйверах видеокарты. При игре в мультиплеерные игры фризы могут возникать из-за нестабильного интернет-соединения.

Артефакты представляют собой различные искажения на мониторе. Это может быть рябь, полосы, мерцания и другие остро выделяющиеся визуальные дефекты. Артефакты при игре могут появиться по целому ряду причин. Проблема может корениться в неисправном мониторе, повреждении или перегреве видеокарты, слабом блоке питания или проблемах с материнской платой. В подавляющем большинстве случаев артефакты во время игрового процесса возникают из-за неисправностей видеокарты.

Заключение

Что касается частоты кадров, то тут уместно правило «чем больше, тем лучше». Комфортное значение FPS зависит от конкретной игры, но в среднем оптимальным значением являются 60 кадров в секунду. Для игры в соревновательные видеоигры желательно держать показатель FPS на максимально возможном и стабильном уровне, так как это влияет на отзывчивость управления и плавность изображения.

Уверен, многие из вас хотели бы себе 144 герцовый монитор, но их стоимость не всем по карману. Многие слышали или смотрели гайды на Youtube о том как поднять герцовку – "разогнать монитор" на стационарном ПК через панель Nvidia или через другие программы (CRU), которые мало того что не у всех работают, так после повышения герцовки (частоты обновления монитора) некорректно отображают цвета. Выставляется неверное разрешение экрана, возникает куча разных мыльных и мерцающих эффектов.

Я расскажу вам как повысить герцовку монитора не только на ПК, но и на ноутбуке, без риска спалить монитор или вызывать артефакты. Информации о том, как это сделать на ноуте, я не нашел во всем интернете. Я также пробовал программу для разгона монитора CRU, но после применения нужных значений она сбрасывает их почти сразу.

В общем, мне удалось поднять частоту экрана на своем ноутбуке MSI с 60-ти до 100!

Теперь в Warface можно выбрать более 60-ти ГЦ, разница колоссальная. На разрешении немного ниже родного значение ГЦ выросло до 120.

Так как в панели Nvidia на ноутбуках отсутствует параметр настройки пользовательских разрешений, в котором и находится возможность выставить герцовку выше той, что у вас уже есть, нужно совершенно другое решение.

[h3]Как повысить количество герц на экране ноутбука или ПК[/h3]

Действия проводились на ноутбуке c Windows 10 на борту, и некоторые элементы могут отличаться. Например, обладателям только дискретной видеокарты не нужно дополнительно заходить в панель настроек Intel, достаточно сделать все настройки в параметрах Windows.

1. Для начала проверьте какая герцовка у вас установлена. Она должна быть 60 Гц.

Для этого зайдите в "Параметры экрана" (ПКМ на Раб. Столе) –> "Дополнительные параметры экрана" –> "Свойства графического адаптера" и откройте вкладку "Монитор". Там откройте пункт "Частота обновления экрана", проверьте количество Гц, которое может выдавать монитор. Если ваш монитор поддерживает больше 60, ставьте больше.

Если у вас значения в пределах 59-60 Гц, идем дальше.

2. Вновь зайдите в "Параметры экрана".

Рядом с основным экраном появится еще один (виртуальный), выделяем его кнопкой мыши.

В пункте "Несколько дисплеев" выбирайте, как показано на рисунке, и жмите применить.

В этом же пункте выбираем значение "Дублировать эти экраны" и жмём применить.

3. Дальше шаг для тех ,у кого процессор Intel с интегрированной видеокартой Intel HD 3000\4000 или подобной. Если у вас другой процессор или нет встроенной графики, то этот шаг можно пропустить.

Переходим в панель встроенной Intel видеокарты и выбираем параметр "Дисплей".

Выбираем дисплей в списке: по умолчанию установлен "Встроенный", нам нужно выбрать наш виртуальный "монитор".

Выставляем нужное нам разрешение (желательно родное разрешение вашего экрана) и выбираем в списке максимальную частоту ГЦ и применяем настройки.

Затем вверху нажимаем на стрелочку у надписи "Дисплей", выбираем в списке "Несколько дисплеев".

Дополнительные дисплеи --> в списке активных дисплеев выбираем главным наш виртуальный "Монитор" и применяем настройки.

4. Снова зайдите в параметры экрана, у вас должно показывать сдвоенный дисплей как на рисунке.

Заходим в дополнительные параметры экрана.

Свойства графического адаптера, и во вкладке "монитор" проверяем доступные частоты экрана.

Выбираем максимальное значение и применяем настройки.

PS: Иногда на ноутбуках нужно переключить дисплей нажатием на функциональные клавиши, или нажать проецировать (можно найти в панели уведомлений в трее, если развернуть все параметры).

1)

На этом все! Если вы всё сделали верно, то в свойствах экрана у вас будет доступно больше стандартных 60ГЦ, и в играх можно смело включать вертикальную синхронизацию. В тех играх, что поддерживают выбор частоты монитора, можно выбрать более 60-ти. Плавность картинки заметно прибавится, да и ощущения от игры будут более яркими!

Важно: Частоту в игре, да и вообще лучше ставить чуть меньше, чем выдает у вас FPS в игре, т.е частота монитора у вас должна быть на уровне с FPS или ниже. Если игра выдает 70-80 FPS, то 120 и более ГЦ ставить смысла нет, вы их не увидите, будет только хуже.Надеюсь, эта информация будет полезна многим, рад был ей поделиться с вами, друзья! Всем удачи на полях сражений.

Про то, что можно разогнать процессор, видеокарту или ОЗУ, слышали, я думаю, большинство пользователей ПК. Однако про то, что можно разогнать еще и монитор, знают немногие, причем зачастую разница от его разгона существеннее и заметнее, чем от разгона другого железа. Также она еще и безопаснее, но об этом ниже.

Теория

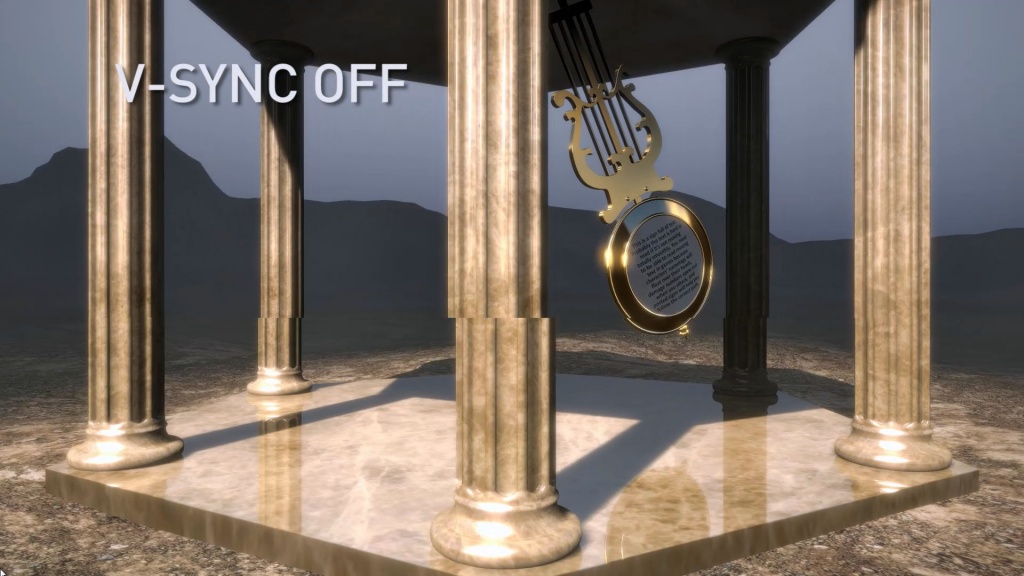

Для начала — что же подразумевается под разгоном матрицы монитора? Подразумевается увеличение частоты обновления монитора со стандартных 60 Гц и на сколько получится — 70-75, бывает и 120, и даже 150 Гц (!). Зачем это нужно? Чтобы повысить плавность картинки. Что означает, что частота обновления монитора — 60 Гц? Это означает, что картинка на экране меняется ровно 60 раз в секунду. При этом видеокарта может выдавать как меньшее количество fps, так и большее. Если количество кадров, выдаваемых видеокартой, меньше частоты обновления, то, значит, какой-то кадр будет дважды (а то и трижды) выведен на экран, что может привести к ощутимым задержкам. Если же количество кадров, выдаваемых видеокартой, больше частоты обновления монитора, то получится так, что на экран будет выдаваться сразу два-три кадра, что приведет к артефактам:

Компромиссом является установка вертикальной синхронизации. В чем ее суть? Она жестко привязывает один кадр, подготовленный видеокартой, к одному обновлению картинки на мониторе. И тут, если ваша видеокарта выдает стабильно больше кадров, чем частота обновления монитора, то вы получите идеальную плавную картинку, ну а ваша видеокарта при этом временами не будет загружена на 100% и будет отдыхать. И именно такой режим работы зачастую используется в системе — к примеру, когда вы скроллите в браузере, артефактов вы не видите, и при этом скроллинг плавный.

Поднятие частоты обновления монитора убивает сразу двух зайцев: во-первых, теперь вертикальная синхронизация будет идти на более высокой частоте, а значит плавность еще повысится (думаю, все видели разницу в роликах на YouTube с 30 и 60 кадрами? Вот тут также). Во-вторых, если ваша видеокарта в играх выдавала больше 60 кадров в секунду, то теперь порог появления артефактов отодвигается до новой частоты обновления, при этом информация на экране будет обновляться чаще, что достаточно важно для динамических игр.

Разумеется, возникает вопрос — насколько это безопасно? Гораздо безопаснее разгона железа: если монитор не может работать на заданной частоте, он просто не включится. Если на заданной частоте он заработал — значит, никаких проблем у вас не будет. Перегрев ему, как в случае с разгоном процессора или видеокарты, точно не грозит.

Практика

Теперь, когда немного разобрались с теорией, можно перейти к практике. Первое, что нужно знать — гонится любой монитор и даже матрицы ноутбуков, но тут есть сразу несколько сдерживающих факторов. Первый — это способ подключения: через DVI при разрешении 1920x1080 вы вряд ли получите свыше 65 Гц — сказывается достаточно низкая пропускная способность интерфейса. Через старые HDMI (до 1.4) при том же разрешении вы скорее всего сможете получить частоту около 75-85 Гц. Ну а через новые HDMI (1.4-2.0), Thunderbolt или DisplayPort ограничений практически нет — можно и 120-165 Гц получить. Аналогично зачастую нет ограничения у матриц ноутбуков, подключенных напрямую к плате. Второй сдерживающий фактор — сама матрица, вернее ее контроллер. Бывает, что даже с быстрым подключением при повышении частоты появляются некоторые артефакты изображения — увы, тут уже ничего не сделаешь, кроме как снижать частоту до последней стабильной.

Теперь поговорим о том, как разгонять. Владельцам видеокарт от Nvidia тут везет — для них алгоритм прост: нужно зайти в панель управления Nvidia, перейти на вкладку «Изменение разрешения», нажать на кнопку «Настройка», в открывшемся окне поставить галку на включении режимов, не поддерживаемых дисплеем, после чего нажать на кнопку «Создать собственное разрешение», и в открывшемся окне мы наконец-то получаем доступ к изменению частоты обновления:

Частоту стоит поднимать на 3-5 Гц, после чего нажимать на кнопку «Тест». Если никаких артефактов не появилось и изображение есть — поднимаете частоту еще выше. Как только появились артефакты или исчезло изображение — снижаете до предыдущей рабочей частоты, и дальше поднимаете уже по 1 Гц — в общем, тут все ровно как при обычном разгоне видеокарты. После того, как нашли нужную частоту обновления, просто сохраняете полученную конфигурацию, и она появится в пользовательских разрешениях.

Как видите, тут риска никакого — если монитор «не завелся» на указанной вами частоте, через 20 секунд система откатит значение частоты на дефолтное. Увы — все так хорошо только с видеокартами от Nvidia, с видеокартами от AMD или Intel все хуже — там в настройках драйвера частоту увеличить нельзя, однако есть универсальное приложение, которое поможет это сделать — называется оно Custom Resolution Utility (CRU), скачать его последнюю версию можно тут.

Сразу предупрежу — проблема программы в том, что у нее нет кнопки Тест, как в случае с Nvidia, поэтому частоты применяются сразу и бесповоротно. Так что если после выставления частоты вы видите черный экран — вам поможет или подключение второго монитора и возврат настроек на дефолтные, или же заход через безопасный режим и проделывание того же самого.

Работать с программой достаточно просто — вы ее запускаете, удаляете все разрешения из стандартных и снимаем все галочки слева (у себя я этого проделывать не буду, ибо уже разогнал матрицу через настройки Nvidia):

Теперь под окном с Detailed resolutions нажимаем на кнопку Add, выставляем Automatic - LCD Reduced и ниже меняем частоту обновления:

Тут принцип тот же — увеличиваем частоту на 3-5 Гц, нажимаем ОК, все сохраняем и перезагружаемся. Теперь заходим в панель AMD (или Intel) и выставляем новую частоту:

Вот, в общем-то, и все — как видите, ничего трудного или опасного нет.

Ну и остается последний вопрос — раз разгоняются почти все матрицы, то почему этого не делают производители с завода? Тут все просто: есть такое понятие, как стандарт, и для частоты обновления мониторов он уже достаточно давно составляет 60 Гц. Поэтому производители, даже если матрица способна работать на 70-80 Гц, все равно ограничивают ее частоту на стандартных 60 Гц. Во-вторых — зачастую все упирается уже в способ подключения. К примеру, передать 1080р60 можно по любому интерфейсу, хоть DVI, хоть Thunderbolt 3. А вот для 1080р80 уже нужен специальный кабель — DVI и старые HDMI уже не подходят. И чтобы не создавать путаницу, производители опять же ограничились 60 герцами.

Что касается вопроса, разгонять или не разгонять — решать вам и только вам. Если у вас получилось увеличить частоту с 60 до 65 Гц — то смысла в таком разгоне нет, разницу вы не увидите. А вот при разгоне уже до 75 и выше Гц разница становится явно видной, так что игра тут стоит свеч. Также следует учитывать, что после разгона повысится нагрузка на видеокарту при обычной работе — ведь ей теперь придется выдавать больше кадров в секунду, так что если вы разгоняете матрицу на ноутбуке — следует учитывать, что у вас несколько снизится время автономной работы.

Читайте также: